本文将为您提供关于天翼校园客户端电脑版怎么安装-天翼校园客户端安装步骤的详细介绍,我们还将为您解释电脑版天翼校园客户端怎么下载的相关知识,同时,我们还将为您提供关于2.nagios客户端安装、Cana

本文将为您提供关于天翼校园客户端电脑版怎么安装-天翼校园客户端安装步骤的详细介绍,我们还将为您解释电脑版天翼校园客户端怎么下载的相关知识,同时,我们还将为您提供关于2.nagios客户端安装、Canal 客户端安装配置、CDH 客户端安装、dubbo客户端安装的实用信息。

本文目录一览:

天翼校园客户端电脑版怎么安装-天翼校园客户端安装步骤(电脑版天翼校园客户端怎么下载)

怎么在电脑上安装天翼校园客户端呢,有哪些步骤呢?那么今天小编就将和大家一起分享天翼校园客户端电安装步骤,有需要的朋友可以来看看这篇文章哦,希望可以帮助到各位朋友。

1.首先,下载天翼校园客户端软件包,解压,双击打开exe安装程序,进入安装向导。

2.选择版本语言,进入版本语言选择安装界面,从下拉选项中选择合适的版本语言,并点击【确定】按钮,即可完成版本语言选择。

3.进入许可协议界面,选择“我已经阅读协议,并接受以上协议的所有条款”,点击【下一步】进入安装路径选择。

4.选择安装路径界面,选择天翼宽带客户端的安装目录,可通过点击【浏览】自行更改安装路径,点击【下一步】进入安装。

5.进入安装进度界面,根据不同的电脑配置,此过程可能会持续几分钟,等待间隙可以观看安装界面上的动画效果了解特色功能,也可以点击小化。按钮将安装界面隐藏至任务栏托盘,再次点击任务栏托盘图标即可恢复查看安装界面。

6.进入安装完成界面,完成安装后,默认勾选“开机时自动启动客户端”和安装推荐的应用,点击【完成】按钮,完成天翼宽带客户端和推荐应用的安装。

以上就是小编分享的天翼校园客户端电安装步骤,有需要的朋友可以来看看哦。

2.nagios客户端安装

在被监控服务器(Linux/unix)上安装Nagios-plugins和nrpe 1、添加用户/usr/sbin/useradd -m nagios

passwd nagioscd /usr/local/src/tarbag

wget http://downloads.sourceforge.net/project/nagiosplug/nagiosplug/1.4.15/nagios-plugins-1.4.15.tar.gz?r=http%3A%2F%2Fwww.nagios.org%2Fdownload%2Fplugins%2F&ts=1331283502&use_mirror=ncu

tar zxvf nagios-plugins-1.4.15.tar.gz -C ../software/

cd ../software/nagios-plugins-1.4.15./configure

make

make installchown -R nagios.nagios /usr/local/nagios/cd /usr/local/src/tarbag

wget http://downloads.sourceforge.net/project/nagios/nrpe-2.x/nrpe-2.13/nrpe-2.13.tar.gz?r=http%3A%2F%2Fexchange.nagios.org%2Fdirectory%2FAddons%2FMonitoring-Agents%2FNRPE--2D-Nagios-Remote-Plugin-Executor%2Fdetails&ts=1331283624&use_mirror=nchc

tar zxvf nrpe-2.13.tar.gz -C ../software/

cd ../software/nrpe-2.13

./configure

make allmake install-pluginmake install-daemonmake install-daemon-configcd /usr/local/nagios/etc/

vi nrpe.cfgallowed_hosts=127.0.0.1,192.168.0.19/usr/local/nagios/bin/nrpe -c /usr/local/nagios/etc/nrpe.cfg -dvi /etc/rc.local/usr/local/nagios/libexec/check_nrpe -H localhostnetstat -tunlp

Active Internet connections (only servers)

Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name

tcp 0 0 0.0.0.0:5666 0.0.0.0:* LISTEN 27387/nrpeiptables -I eth0 -p tcp -m tcp –dport 5666 -j ACCEPTcommand[check_users]=/usr/local/nagios/libexec/check_users -w 5 -c 10

command[check_load]=/usr/local/nagios/libexec/check_load -w 15,10,5 -c 30,25,20

command[check_hda1]=/usr/local/nagios/libexec/check_disk -w 20% -c 10% -p /dev/hda1

command[check_zombie_procs]=/usr/local/nagios/libexec/check_procs -w 5 -c 10 -s Z

command[check_total_procs]=/usr/local/nagios/libexec/check_procs -w 150 -c 200command[check_swap]=/usr/local/nagios/libexec/check_swap -w 20% -c 10%command[check_disk_root]=/usr/local/nagios/libexec/check_disk -w 20% -c 10% -p //usr/local/nagios/bin/nrpe -c /usr/local/nagios/etc/nrpe.cfg -d

Canal 客户端安装配置

一、canal 安装路径

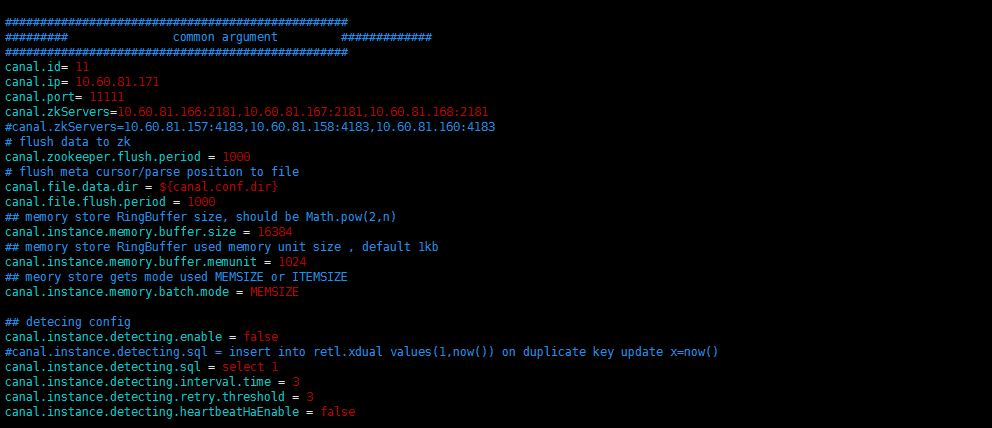

二、canal 配置文件 canal.properties

#################################################

######### common argument #############

#################################################

canal.id= 11

canal.ip= 10.60.81.171

canal.port= 11111

canal.zkServers=10.60.81.166:2181,10.60.81.167:2181,10.60.81.168:2181

#canal.zkServers=10.60.81.157:4183,10.60.81.158:4183,10.60.81.160:4183

# flush data to zk

canal.zookeeper.flush.period = 1000

# flush meta cursor/parse position to file

canal.file.data.dir = ${canal.conf.dir}

canal.file.flush.period = 1000

## memory store RingBuffer size, should be Math.pow(2,n)

canal.instance.memory.buffer.size = 16384

## memory store RingBuffer used memory unit size , default 1kb

canal.instance.memory.buffer.memunit = 1024

## meory store gets mode used MEMSIZE or ITEMSIZE

canal.instance.memory.batch.mode = MEMSIZE

## detecing config

canal.instance.detecting.enable = false

#canal.instance.detecting.sql = insert into retl.xdual values(1,now()) on duplicate key update x=now()

canal.instance.detecting.sql = select 1

canal.instance.detecting.interval.time = 3

canal.instance.detecting.retry.threshold = 3

canal.instance.detecting.heartbeatHaEnable = false

# support maximum transaction size, more than the size of the transaction will be cut into multiple transactions delivery

canal.instance.transaction.size = 1024

# mysql fallback connected to new master should fallback times

canal.instance.fallbackIntervalInSeconds = 60

# network config

canal.instance.network.receiveBufferSize = 16384

canal.instance.network.sendBufferSize = 16384

canal.instance.network.soTimeout = 30

# binlog filter config

canal.instance.filter.druid.ddl = true

canal.instance.filter.query.dcl = false

canal.instance.filter.query.dml = false

canal.instance.filter.query.ddl = false

canal.instance.filter.table.error = false

canal.instance.filter.rows = false

# binlog format/image check

canal.instance.binlog.format = ROW,STATEMENT,MIXED

canal.instance.binlog.image = FULL,MINIMAL,NOBLOB

# binlog ddl isolation

canal.instance.get.ddl.isolation = false

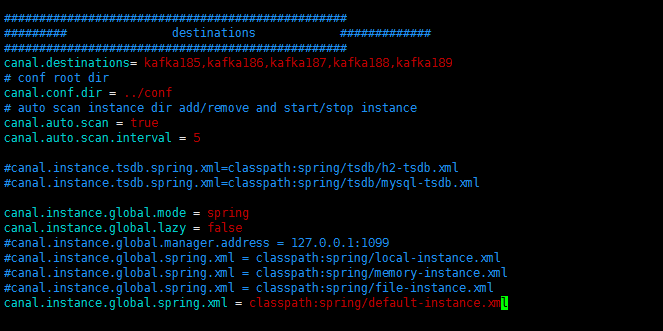

#################################################

######### destinations #############

#################################################

canal.destinations= kafka185,kafka186,kafka187,kafka188,kafka189

# conf root dir

canal.conf.dir = ../conf

# auto scan instance dir add/remove and start/stop instance

canal.auto.scan = true

canal.auto.scan.interval = 5

#canal.instance.tsdb.spring.xml=classpath:spring/tsdb/h2-tsdb.xml

#canal.instance.tsdb.spring.xml=classpath:spring/tsdb/mysql-tsdb.xml

canal.instance.global.mode = spring

canal.instance.global.lazy = false

#canal.instance.global.manager.address = 127.0.0.1:1099

#canal.instance.global.spring.xml = classpath:spring/local-instance.xml

#canal.instance.global.spring.xml = classpath:spring/memory-instance.xml

#canal.instance.global.spring.xml = classpath:spring/file-instance.xml

canal.instance.global.spring.xml = classpath:spring/default-instance.xml

三、canal 配置实例文件

1、kafka185/instance.properties

# position info

#canal.instance.master.address=10.60.81.161:3306

canal.instance.master.address=10.60.81.185:3311

canal.instance.master.journal.name=

canal.instance.master.position=

canal.instance.master.timestamp=

#1483200000000

# table meta tsdb info

canal.instance.tsdb.enable=true

canal.instance.tsdb.dir=${canal.file.data.dir:../conf}/${canal.instance.destination:}

canal.instance.tsdb.url=jdbc:h2:${canal.instance.tsdb.dir}/h2;CACHE_SIZE=1000;MODE=MYSQL;

#canal.instance.tsdb.url=jdbc:mysql://127.0.0.1:3306/canal_tsdb

#canal.instance.tsdb.dbUsername=canal

#canal.instance.tsdb.dbPassword=canal

#canal.instance.standby.address =

#canal.instance.standby.journal.name =

#canal.instance.standby.position =

#canal.instance.standby.timestamp =

# username/password

canal.instance.dbUsername=canal

canal.instance.dbPassword=Canal@123

canal.instance.defaultDatabaseName=test

canal.instance.connectionCharset=UTF-8

# table regex

canal.instance.filter.regex=.*\\..*

# table black regex

canal.instance.filter.black.regex=

#################################################

2、kafka186/instance.properties

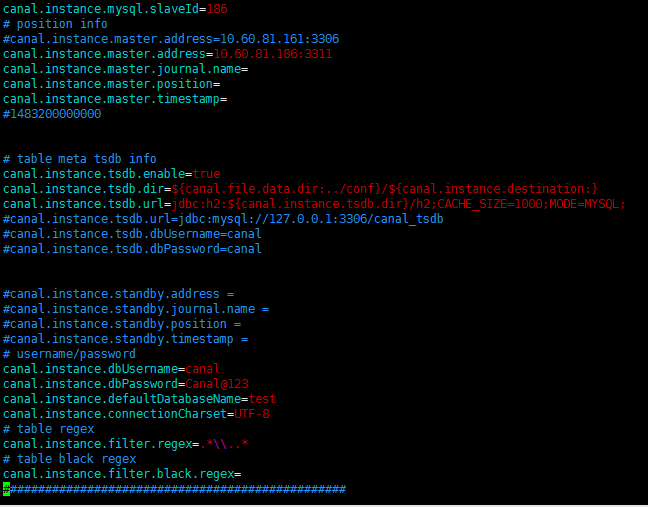

#################################################

## mysql serverId

canal.instance.mysql.slaveId=186

# position info

#canal.instance.master.address=10.60.81.161:3306

canal.instance.master.address=10.60.81.186:3311

canal.instance.master.journal.name=

canal.instance.master.position=

canal.instance.master.timestamp=

#1483200000000

# table meta tsdb info

canal.instance.tsdb.enable=true

canal.instance.tsdb.dir=${canal.file.data.dir:../conf}/${canal.instance.destination:}

canal.instance.tsdb.url=jdbc:h2:${canal.instance.tsdb.dir}/h2;CACHE_SIZE=1000;MODE=MYSQL;

#canal.instance.tsdb.url=jdbc:mysql://127.0.0.1:3306/canal_tsdb

#canal.instance.tsdb.dbUsername=canal

#canal.instance.tsdb.dbPassword=canal

#canal.instance.standby.address =

#canal.instance.standby.journal.name =

#canal.instance.standby.position =

#canal.instance.standby.timestamp =

# username/password

canal.instance.dbUsername=canal

canal.instance.dbPassword=Canal@123

canal.instance.defaultDatabaseName=test

canal.instance.connectionCharset=UTF-8

# table regex

canal.instance.filter.regex=.*\\..*

# table black regex

canal.instance.filter.black.regex=

#################################################

CDH 客户端安装

## 原理 CDH 的客户端,指得是能够以客户端方式,访问 CDH 集群服务的各类工具的集合。主要包括 hdfs,hive 和 hbase

## 操作

-

### 前提条件 需要事先装好 JDK

-

### 获取介质

安装 CDH 客户端和安装服务端没啥区别,安装介质也是一样的。

cd /tmp wget http://archive.cloudera.com/cdh5/parcels/5.10.1/CDH-5.10.1-1.cdh5.10.1.p0.10-el7.parcel -

### 部署介质

安装客户端,就不需要像安装服务端那么繁琐,也不需要安装 cloudera manager。简单说,就是把需要的文件解包,放好即可。

mkdir /opt/cloudera/ mkdir /opt/cloudera/parcels cd /opt/cloudera/parcels tar xvf /tmp/CDH-5.10.1-1.cdh5.10.1.p0.10-el7.parcel ln –s CDH-5.10.1-1.cdh5.10.1.p0.10 CDH -

### 配置客户端

配置客户端主要就是配置文件、环境变量和路径的设置。

#从hadoop集群获取配置文件 a.在Cloudera Manager管理界面中,选择Hive服务 b.在“操作”菜单中选择“下载客户端配置文件” c.将配置文件上传Hadoop客户端/tmp目录,文件名为hive.zip d.在Hadoop客户端执行: mkdir /opt/cloudera/etc/ cd /opt/cloudera/etc unzip /tmp/hive.zip #从hadoop集群获取hbase配置文件 a.在Hadoop客户端执行: scp -r root@slave4:/etc/hbase /etc/ #slave4是hadoop集群中的一个节点 #从hadoop集群获取hosts配置文件,因为来自集群的配置文件中,可能会本地无法解析的主机名,所以需要拿到集群的hosts文件,用于解析ip地址。 a.在Hadoop客户端执行: scp root@slave4:/etc/hosts /tmp/ #slave4是hadoop集群中的一个节点 cat /tmp/host >> /etc/hosts #修改Hadoop客户端环境变量,将以下命令追加到/etc/profile里,确保每个用户都有同样一套环境变量 export JAVA_HOME="/usr/lib/jvm/java-1.7.0-openjdk-1.7.0.45.x86_64" export HADOOP_HOME="/opt/cloudera/parcels/CDH" export HIVE_HOME="/opt/cloudera/parcels/CDH/lib/hive" export HBASE_HOME="/opt/cloudera/parcels/CDH/lib/hbase" export HCAT_HOME="/opt/cloudera/parcels/CDH" export HADOOP_CONF_DIR="/opt/cloudera/etc/hive-conf" export HIVE_CONF="/opt/cloudera/etc/hive-conf/" export YARN_CONF_DIR="/opt/cloudera/etc/hive-conf" export CDH_MR2_HOME=$HADOOP_HOME/lib/hadoop-mapreduce export PATH=${JAVA_HOME}/bin:${HADOOP_CONF_DIR}:${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin:${HBASE_HOME}/bin:${HIVE_HOME}/bin:${HCAT_HOME}/bin:${PATH} -

### 连通性验证

a.验证HDFS hadoop fs –ls / #如果可以列出目录,证明HDFS客户端配置成功; b.验证HIVE beeline -u "jdbc:hive2://slave4:10000/default;principal=kylin/slave4@MCITP.COM" #如果是基于kerberos登录,使用这种方式; beeline -u "jdbc:hive2://slave4:10000/default" #如果是基本认证登录,则采用这种方式 show databases;#如果可以进入beeline命令行模式,而且可以显示默认数据库defaul,证明beeline客户端配置成功。 c.验证HBASE hbase shell list #如果可以进入hbase shell,并且可以列出hbase中的表名,证明hbase客户端配置成功。

dubbo客户端安装

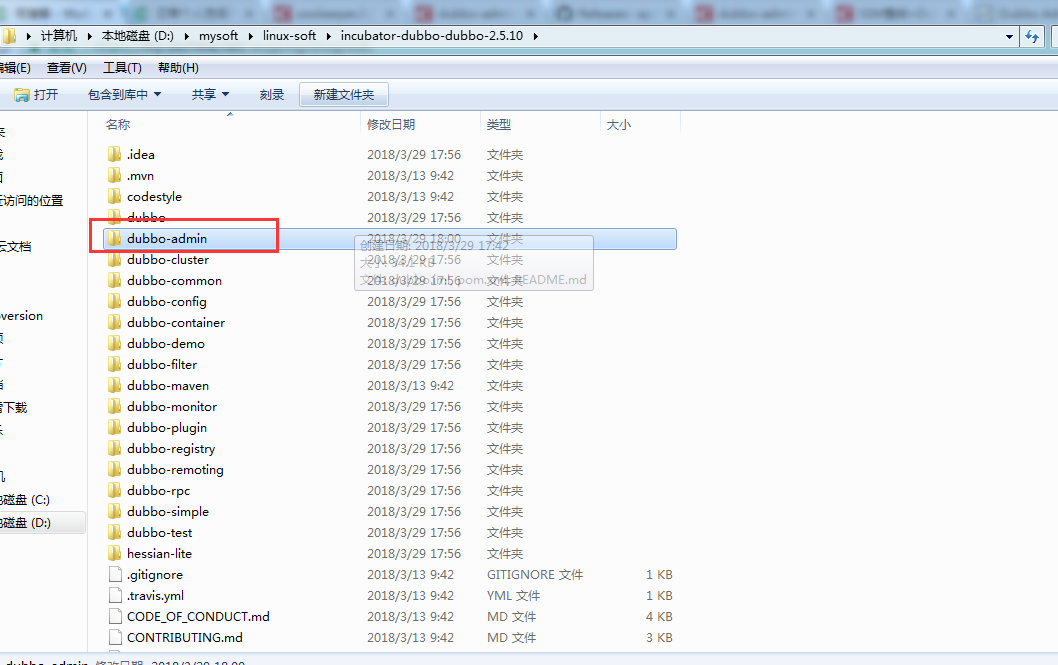

下载源码:dubbo-2.5.10

安装mavn:教程

下载tomcat:tomcat8.5.29

jdk:1.8

百度网盘:dubbo2.5.10 密码:rb4z

下载下来是这样的一个目录结构:

但是这里我们只关心dubbo-admin这个文件夹。

其实下面所谓配置的目的就是为了得到war包,war包网上也有,但是下载了很多下来都会有问题,原因可能是每个人的电脑jdk版本或其他环境不一样,因此我们自己打包一个war就好。

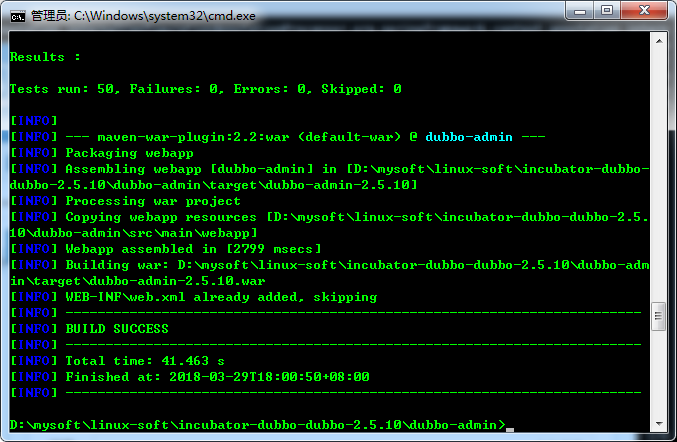

打包war包,进入dubbo-admin这个文件目录 运行命令:

mvn package -Dmaven.skip.test=true

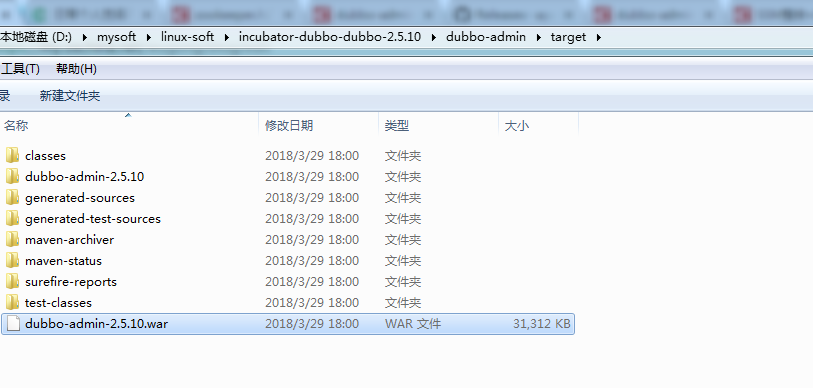

第二步我们得到dubbo-admin*.war,下面我们将这个war包部署到tomcat上。

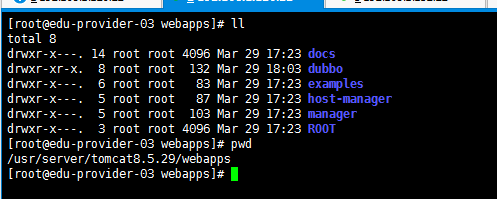

把dubbo-admin-*.war放到tomcat的webapps目录下:

我放到dubbo下,然后解压....此处略过好多字,作为开发应该会在Linux进行war包解压之类的

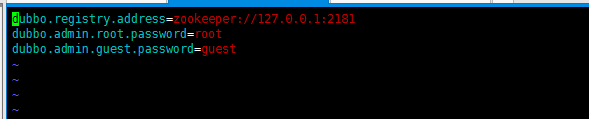

配置:vim dubbo/WEB-INF/dubbo.properties,修改一个zookeeper配置信息

首先需要启动zookeeper

然后启动tomcat

关于天翼校园客户端电脑版怎么安装-天翼校园客户端安装步骤和电脑版天翼校园客户端怎么下载的介绍已经告一段落,感谢您的耐心阅读,如果想了解更多关于2.nagios客户端安装、Canal 客户端安装配置、CDH 客户端安装、dubbo客户端安装的相关信息,请在本站寻找。

本文标签: