如果您对elasticsearch(es)集群恢复触发配置和LocalGateway参数感兴趣,那么这篇文章一定是您不可错过的。我们将详细讲解elasticsearch(es)集群恢复触发配置的各种细

如果您对elasticsearch(es) 集群恢复触发配置和Local Gateway参数感兴趣,那么这篇文章一定是您不可错过的。我们将详细讲解elasticsearch(es) 集群恢复触发配置的各种细节,并对Local Gateway参数进行深入的分析,此外还有关于011,elasticsearch--[L13]-- 图解 Elasticsearch 容错机制:master 选举,replica 容错,数据恢复、day81(Sentinel,SpringGateway 网关,csmall项目网关,Elasticsearch概述)、docker 部署 elasticsearch + elasticsearch-head + elasticsearch-head 跨域问题 + IK 分词器、Elasticsearch CentOS6.5下安装ElasticSearch6.2.4+elasticsearch-head+Kibana的实用技巧。

本文目录一览:- elasticsearch(es) 集群恢复触发配置(Local Gateway参数)(es集群恢复要多久)

- 011,elasticsearch--[L13]-- 图解 Elasticsearch 容错机制:master 选举,replica 容错,数据恢复

- day81(Sentinel,SpringGateway 网关,csmall项目网关,Elasticsearch概述)

- docker 部署 elasticsearch + elasticsearch-head + elasticsearch-head 跨域问题 + IK 分词器

- Elasticsearch CentOS6.5下安装ElasticSearch6.2.4+elasticsearch-head+Kibana

elasticsearch(es) 集群恢复触发配置(Local Gateway参数)(es集群恢复要多久)

elasticsearch(es) 集群恢复触发配置(Local Gateway)

当你集群重启时,几个配置项影响你的分片恢复的表现。 首先,我们需要明白如果什么也没配置将会发生什么。

想象一下假设你有 10 个节点,每个节点只保存一个分片,这个分片是一个主分片或者是一个副本分片,或者说有一个有 5 个主分片/1 个副本分片的索引。有时你需要为整个集群做离线维护(比如,为了安装一个新的驱动程序), 当你重启你的集群,恰巧出现了 5 个节点已经启动,还有 5 个还没启动的场景。

假设其它 5 个节点出问题,或者他们根本没有收到立即重启的命令。不管什么原因,你有 5 个节点在线上,这五个节点会相互通信,选出一个 master,从而形成一个集群。 他们注意到数据不再均匀分布,因为有 5 个节点在集群中丢失了,所以他们之间会立即启动分片复制。

最后,你的其它 5 个节点打开加入了集群。这些节点会发现 它们 的数据正在被复制到其他节点,所以他们删除本地数据(因为这份数据要么是多余的,要么是过时的)。 然后整个集群重新进行平衡,因为集群的大小已经从 5 变成了 10。

在整个过程中,你的节点会消耗磁盘和网络带宽,来回移动数据,因为没有更好的办法。对于有 TB 数据的大集群,这种无用的数据传输需要 很长时间 。如果等待所有的节点重启好了,整个集群再上线,所有的本地的数据都不需要移动。

本地网关

本地网关模块在整个集群重新启动时存储集群状态和分片数据。

以下参数是配置 尝试恢复集群状态和集群数据 的触发点,必须在每个主节点上都做做如下配置。

-

gateway.expected_nodes

预期在集群中的(数据或主)节点数。只要预期的节点数已加入集群,就会启动本地分片的恢复。默认为0 -

gateway.expected_master_nodes

预期在集群中的主节点数。一旦预期的主节点数加入集群,就会开始恢复本地分片。默认为0 -

gateway.expected_data_nodes

预期在集群中的数据节点数。一旦预期数量的节点已加入集群,就会启动本地分片的恢复。默认为0 -

gateway.recover_after_time

如果未达到预期的节点数,则恢复过程将等待配置的时间量,然后再尝试恢复。如果只要配置了expected_nodes,则默认这个参数值为5m

一旦recover_after_time持续时间超时,只要满足以下条件,恢复就会开始:

-

gateway.recover_after_nodes

只要此许多数据或主节点已加入集群,即可恢复。 -

gateway.recover_after_master_nodes

只要这么多主节点已加入集群,就可以恢复。 -

gateway.recover_after_data_nodes

只要这么多数据节点已加入集群,就可以恢复。

上述描述来自官方文档Local Gateway的描述,看完之后有点绕,还是不能完全理解。

stack overflow 上的解释

stack overflow 上的描述相对好理解很多:Difference between expected_nodes and recover_after_nodes parameters。这里做一下搬运工,给出结论。

**满足 gateway.recover_* 条件之后会触发记时器,有两种情况 **

- 在

recovery_after_time为用完,满足gateway.excepted_*条件则立即执行数据同步 -

recovery_after_time时间用完,那么也会开始执行数据同步

举个栗子

gateway:

recover_after_nodes: 3

expected_nodes: 5

虽然上面没有配置 recovery_after_time 属性,但是因为配置了 expected_nodes 所以会有默认值 5m,就是5分钟。

假设集群中有5个node,其中3个node已经恢复正常使用,也就是达到了 recover_after_nodes: 3 的条件。那么如果5分钟之内一共有5个node恢复正常使用,那么会立即进行集群的数据恢复,要不然就是过了5分钟node数量打不到5个,也会触发数据恢复。

欢迎转载,但请注明本文链接,谢谢你。

2018.7.7 17:31

![011,elasticsearch--[L13]-- 图解 Elasticsearch 容错机制:master 选举,replica 容错,数据恢复 011,elasticsearch--[L13]-- 图解 Elasticsearch 容错机制:master 选举,replica 容错,数据恢复](http://www.gvkun.com/zb_users/upload/2025/01/8659aeb6-f15c-430a-8998-7a229f8ab8c11737856654909.jpg)

011,elasticsearch--[L13]-- 图解 Elasticsearch 容错机制:master 选举,replica 容错,数据恢复

课程大纲

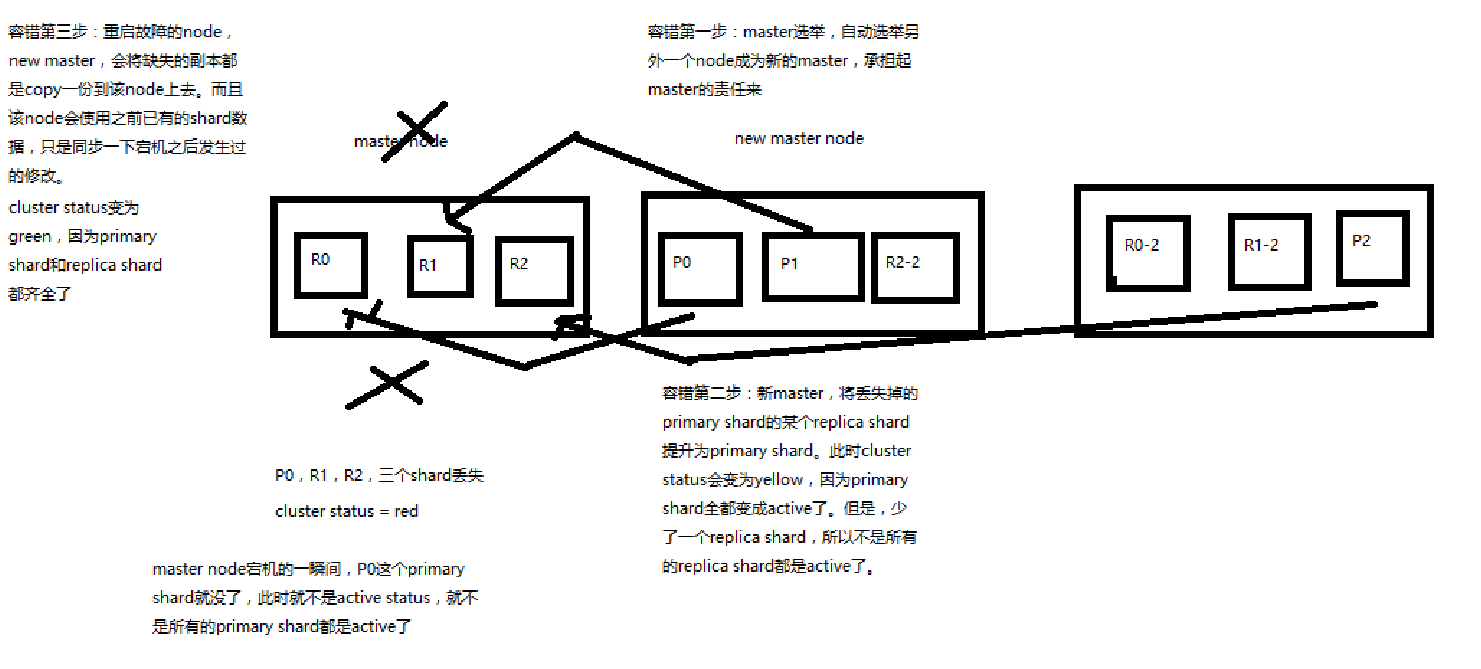

1、图解 Elasticsearch 容错机制:master 选举,replica 容错,数据恢复

(1)9 shard,3 node

(2)master node 宕机,自动 master 选举,red

(3)replica 容错:新 master 将 replica 提升为 primary shard,yellow

(4)重启宕机 node,master copy replica 到该 node,使用原有的 shard 并同步宕机后的修改,green

day81(Sentinel,SpringGateway 网关,csmall项目网关,Elasticsearch概述)

day81(Sentinel,SpringGateway 网关,csmall项目网关,Elasticsearch概述)

1.续 Sentinel

流控与降级

上次课我们完成了使用Sentinel实现QPS或并发线程数进行流控的操作

但是被流控的请求只有一个错误,没有错误提示,不方便给用户反馈

我们应该在开发时,对于被流控的请求给与相关提示

StockController中编写代码如下

@Autowired

private IStockService stockService;

@PostMapping("/reduce/count")

@ApiOperation("减少商品库存业务")

// @SentinelResource标记的方法会被Sentinel监控

// value的值是这个监控的名称,我们可以在"仪表台"中看到

// blockHandler的值指定了请求被限流时运行的方法名称

@SentinelResource(value = "减少库存方法(控制器)",blockHandler = "blockerror")

public JsonResult reducecommodityCount(StockReduceCountDTO stockReduceCountDTO){

stockService.reducecommodityCount(stockReduceCountDTO);

return JsonResult.ok("商品库存减少完成!");

}

// Sentinel 限流方法应该满足如下要求

// 1.必须是public修改

// 2.返回值类型必须和控制方法一致(JsonResult)

// 3.方法名称要和控制器方法限流注解中规定的名称一致(blockerror)

// 4.参数列表必须和控制器一致,可以在所以参数后声明BlockException来获得限流异常

public JsonResult blockerror(StockReduceCountDTO stockReduceCountDTO,

BlockException e){

return JsonResult.Failed(ResponseCode.BAD_REQUEST,"服务器忙,请稍后再试");

}

上面方法定义了被Sentinel限流时运行的方法

下面我们要学习降级的功能

降级功能和我们之前学习的统一异常处理类有相似的地方

但是降级是Sentinel的功能

@PostMapping("/reduce/count")

@ApiOperation("减少商品库存业务")

// @SentinelResource标记的方法会被Sentinel监控

// value的值是这个监控的名称,我们可以在"仪表台"中看到

// blockHandler的值指定了请求被限流时运行的方法名称

@SentinelResource(value = "减少库存方法(控制器)",blockHandler = "blockerror",

fallback = "fallbackerror")

public JsonResult reducecommodityCount(StockReduceCountDTO stockReduceCountDTO){

// 生成随机出触发降级流程

if(Math.random()<0.5){

throw new

CoolSharkServiceException(ResponseCode.INTERNAL_SERVER_ERROR,"异常");

}

stockService.reducecommodityCount(stockReduceCountDTO);

return JsonResult.ok("商品库存减少完成!");

}

// 这个方法是Sentinel注解中fallback属性指定的降级方法

// 当前控制器方法运行发生异常时,Sentinel会运行下面的降级方法

// 降级方法中,可以不直接结束请求,而去运行一些代替代码或者补救措施

// 让用户获得最低限度的响应

public JsonResult fallbackerror(StockReduceCountDTO stockReduceCountDTO){

return JsonResult.Failed(ResponseCode.BAD_REQUEST,"因为运行异常,服务降级");

}

blockHandler和fallback的区别

两者都是不能正常调用资源返回值的顶替处理逻辑.

blockHander只能处理BlockException 流控限制之后的逻辑.

fallback处理的是资源调用异常的降级逻辑.

课堂作业

为business模块控制器的buy方法添加Sentinel流控和降级的功能

流控时输出"服务器忙",降级时输出"服务降级"

1.pom文件

2.yml(port属性不能和stock模块的相同8722)

3.修改控制器代码(注解,流控和降级方法)

2.SpringGateway 网关

奈非框架简介

早期(2020年前)奈非提供的微服务组件和框架受到了很多开发者的欢迎

这些框架和Spring Cloud Alibaba的对应关系我们要知道

Nacos对应Eureka 都是注册中心

dubbo对应ribbon+feign都是实现微服务间调用

Sentinel对应Hystrix都是项目限流熔断降级组件

Gateway对应zuul都是项目的网关

Gateway不是阿里巴巴的而是Spring提供的

什么是网关

"网关"网是网络,关是关口\关卡

关口\关卡的意思就是"统一入口"

网关:就是网络中的统一入口

程序中的网关就是微服务项目提供的外界所有请求统一访问的微服务项目

因为提供了统一入口之后,方便对所有请求进行统一的检查和管理

网关的主要功能有

- 将所有请求统一由经过网关

- 网关可以对这些请求进行检查

- 网关方便记录所有请求的日志

- 网关可以统一将所有请求路由到正确的模块\服务上

路由的近义词就是"分配"

Spring Gateway简介

我们使用Spring Gateway作为当前项目的网关框架

Spring Gateway是Spring自己编写的,也是SpringCloud中的组件

SpringGateway官网

https://docs.spring.io/spring-cloud-gateway/docs/current/reference/html/

网关项目git地址

https://gitee.com/jtzhanghl/gateway-demo.git

简单网关演示

网关是一个我们创建的项目,不是一个需要安装的软件

网关也是当前微服务项目的一员,也要注册到Nacos,所以保证Nacos的运行

运行之前,我们看一下网关演示项目已经存在的基本结构

beijing和shanghai是编写好的两个项目

gateway没有编写yml文件配置

要想实现网关的路由效果需要修改yml文件如下

server:

port: 9000

spring:

application:

name: gateway

cloud:

nacos:

discovery:

server-addr: localhost:8848

gateway:

routes: # gateway开始配置路由信息

- id: gateway-shanghai

uri: lb://shanghai

predicates:

- Path=/sh/**

# 如果java访问这个数字元素的方式:spring.cloud.gateway.routes[0].predicates[0]

# routes属性实际上是一个数组,yml文件中出现 "- ...."配置时表示当前配置时一个数组元素

- id: gateway-beijing # 这个配置指定这个路由的名称,这个名称和其他任何位置没有关联

# 只需要注意不能再和其他路由名称重复

# uri设置路由的目标

# lb是LoadBalance(负载均衡)的缩写,beijing是注册到nacos的服务名称

uri: lb://beijing

# 我们需要设置一个条件,当访问路径满足特定条件是,使用当前路由规则

predicates:

# predicates翻译为断言,所谓断言就是判断一个条件是否满足

# Path 是路径断言,意思是满足路径为XXX时使用这个路由

- Path=/bj/**

# http://localhost:9000/bj/show 会路由到 9001/bj/show

内置断言

断言就是判断一个条件,如果条件满足就执行某个操作

predicates就是断言的意思

我们前面章节使用的Path就是内置断言中的一种,指访问的路径是否满足条件

除了路径断言之外,还有很多内置断言常见的内置断言列表

- after

- before

- between

- cookie

- header

- host

- method

- path

- query

- remoteaddr

时间相关

after,before,between

在指定时间之后,之前或之间

判断是否满足时间条件,如果满足才允许访问

我们先使用下面代码获得当前包含时区的系统时间表

zoneddatetime.Now()

使用After设置必须在指定时间之后访问

- id: gateway-shanghai

uri: lb://shanghai

predicates:

- Path=/sh/**

- After=2022-06-24T15:30:30.999+08:00[Asia/Shanghai]

使用Before设置必须在指定时间之后访问

- id: gateway-shanghai

uri: lb://shanghai

predicates:

- Path=/sh/**

- Before=2022-06-24T15:34:00.999+08:00[Asia/Shanghai]

使用Between设置必须在指定时间之间访问

- id: gateway-shanghai

uri: lb://shanghai

predicates:

- Path=/sh/**

- Between=2022-06-24T15:34:00.999+08:00[Asia/Shanghai],2022-06-24T15:36:20.999+08:00[Asia/Shanghai]

要求指定参数

Query断言,要求必须包含指定的参数才能访问资源

- id: gateway-shanghai

uri: lb://shanghai

predicates:

- Path=/sh/**

- Query=name

内置过滤器

Gateway还提供的内置过滤器

不要和我们学习的filter混淆

内置过滤器允许我们在路由请求到目标资源的同时,对这个请求进行一些加工或处理

下面我们使用AddRequestParameter过滤器,想请求中添加参数

- id: gateway-shanghai

uri: lb://shanghai

predicates:

- Path=/sh/**

- Query=name

filters:

- AddRequestParameter=age,80

shanghai项目的控制器接收这个参数

@GetMapping("/show")

public String show(String name,Integer age){

return "这里是上海!"+name+","+age;

}

重启网关和shanghai项目

例如输入如下路径

http://localhost:9000/sh/show?name=tom

因为过滤器的存在,控制可以获取网关过滤器添加的参数值

其他内置过滤器和自定义过滤器的使用,同学们可以查阅相关文档自己了解

动态路由

如果项目微服务数量多

那么gateway项目yml文件配置也会越来越冗余,维护的工作量也会越来越大

所谓我们希望能够根据固定特征自动的路由到每个微服务模块

这个功能就是SpringGateway的动态路由功能

只需要在配置文件中配置开启动态路由功能即可

spring:

application:

name: gateway

cloud:

nacos:

discovery:

server-addr: localhost:8848

gateway:

discovery:

locator:

# 开启Spring Gateway的动态路由功能

# 规则是根据注册到Nacos的项目名称作为路径的前缀,就可以访问到指定项目了

enabled: true

开启之后访问项目的格式以beijing为例

localhost:9000/beijing/bj/show

3.csmall项目网关

创建gateway网关子项目

父子相认

子项目pom文件为

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 https://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<parent>

<groupId>cn.tedu</groupId>

<artifactId>csmall</artifactId>

<version>0.0.1-SNAPSHOT</version>

</parent>

<groupId>cn.tedu</groupId>

<artifactId>gateway</artifactId>

<version>0.0.1-SNAPSHOT</version>

<name>gateway</name>

<description>Demo project for Spring Boot</description>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-nacos-discovery</artifactId>

</dependency>

<!-- 网负载均衡支持 -->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-loadbalancer</artifactId>

</dependency>

<!-- Spring Gateway 网关依赖 -->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-gateway</artifactId>

</dependency>

<!--聚合网关 knife4j-->

<dependency>

<groupId>com.github.xiaoymin</groupId>

<artifactId>knife4j-spring-boot-starter</artifactId>

</dependency>

</dependencies>

</project>

也删除test测试文件夹

application.yml文件内容如下

spring:

application:

name: gateway-server

cloud:

nacos:

discovery:

server-addr: localhost:8848

gateway:

discovery:

locator:

# 开启网关动态路由

enabled: true

main:

web-application-type: reactive

server:

port: 10000

knife4j网关配置

我们希望配置网关之后,在使用knife4j测试时

就不来回切换端口号了

我们需要配置Knife4j才能实现

创建包cn.tedu.gateway.config包

SwaggerProvider

@Component

public class SwaggerProvider implements SwaggerResourcesProvider {

/**

* 接口地址

*/

public static final String API_URI = "/v2/api-docs";

/**

* 路由加载器

*/

@Autowired

private RouteLocator routeLocator;

/**

* 网关应用名称

*/

@Value("${spring.application.name}")

private String applicationName;

@Override

public List<SwaggerResource> get() {

//接口资源列表

List<SwaggerResource> resources = new ArrayList<>();

//服务名称列表

List<String> routeHosts = new ArrayList<>();

// 获取所有可用的应用名称

routeLocator.getRoutes().filter(route -> route.getUri().getHost() != null)

.filter(route -> !applicationName.equals(route.getUri().getHost()))

.subscribe(route -> routeHosts.add(route.getUri().getHost()));

// 去重,多负载服务只添加一次

Set<String> existsServer = new HashSet<>();

routeHosts.forEach(host -> {

// 拼接url

String url = "/" + host + API_URI;

//不存在则添加

if (!existsServer.contains(url)) {

existsServer.add(url);

SwaggerResource swaggerResource = new SwaggerResource();

swaggerResource.setUrl(url);

swaggerResource.setName(host);

resources.add(swaggerResource);

}

});

return resources;

}

}

cn.tedu.gateway.controller

SwaggerController类

@RestController

@RequestMapping("/swagger-resources")

public class SwaggerController {

@Autowired(required = false)

private SecurityConfiguration securityConfiguration;

@Autowired(required = false)

private UiConfiguration uiConfiguration;

private final SwaggerResourcesProvider swaggerResources;

@Autowired

public SwaggerController(SwaggerResourcesProvider swaggerResources) {

this.swaggerResources = swaggerResources;

}

@GetMapping("/configuration/security")

public Mono<ResponseEntity<SecurityConfiguration>> securityConfiguration() {

return Mono.just(new ResponseEntity<>(

Optional.ofNullable(securityConfiguration).orElse(SecurityConfigurationBuilder.builder().build()), HttpStatus.OK));

}

@GetMapping("/configuration/ui")

public Mono<ResponseEntity<UiConfiguration>> uiConfiguration() {

return Mono.just(new ResponseEntity<>(

Optional.ofNullable(uiConfiguration).orElse(UiConfigurationBuilder.builder().build()), HttpStatus.OK));

}

@GetMapping("")

public Mono<ResponseEntity> swaggerResources() {

return Mono.just((new ResponseEntity<>(swaggerResources.get(), HttpStatus.OK)));

}

}

cn.tedu.gateway.filter

SwaggerHeaderFilter类

@Component

public class SwaggerHeaderFilter extends AbstractGatewayFilterFactory {

private static final String HEADER_NAME = "X-Forwarded-Prefix";

private static final String URI = "/v2/api-docs";

@Override

public GatewayFilter apply(Object config) {

return (exchange, chain) -> {

ServerHttpRequest request = exchange.getRequest();

String path = request.getURI().getPath();

if (!StringUtils.endsWithIgnoreCase(path,URI )) {

return chain.filter(exchange);

}

String basePath = path.substring(0, path.lastIndexOf(URI));

ServerHttpRequest newRequest = request.mutate().header(HEADER_NAME, basePath).build();

ServerWebExchange newExchange = exchange.mutate().request(newRequest).build();

return chain.filter(newExchange);

};

}

}

启动Nacos\Seata\Sentinel

启动cart\stock\order\business

在保证一般访问正常的情况下

再启动gateway

可以通过下面路径访问之前的各个模块的业务

http://localhost:10000/nacos-stock/doc.html

http://localhost:10000/nacos-cart/doc.html

http://localhost:10000/nacos-order/doc.html

http://localhost:10000/nacos-business/doc.html

如果不使用网关一切正常,但是启动网关访问失败的话,就是gateway项目配置问题

Gateway和SpringMvc依赖冲突问题和解决

网关依赖

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-gateway</artifactId>

</dependency>

SpringMvc依赖

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

这两个依赖在同一个项目中时,默认情况下启动会报错

SpringMvc依赖中自带一个Tomcat服务器

而Gateway依赖中自带一个Netty服务器

因为在启动服务时这个两个服务器都想启动,会因为争夺端口号和主动权而发生冲突

我们需要在yml文件中添加配置解决

spring:

main:

web-application-type: reactive

4.Elasticsearch概述

什么是Elasticsearch

elastic:富有弹性的

search:搜索

在计算机开发界简称ES

这个软件不是SpringCloud的组件,甚至其他语言都可以使用它

是一个java开发的软件,所以启动需要java环境变量

功能是从大量数据中根据指定的关键字搜索出匹配的结果

这样的软件有一个名称全文搜索引擎

使用它的方式是访问它提供的控制器方法,它开发了多种控制器方法

访问不同方法实现对数据的增删改查

ES也是将数据保存在硬盘上的

常见面试题ES的实现结构

java有一套名为Lucene的API

是搜索引擎的核心支持,Elasticsearch在Lucene的基础上开发出了一个功能全面的开箱即用的全文搜索引擎

市面上ES的竞品有

Solr/MongoDB

为什么使用Elasticsearch

因为我们之前学习的所有关系型数据库都有一个严重的性能缺陷

MysqL\mariaDB\oracle\DB2等

就是前模糊的模糊查询不能使用索引

select * from spu where spu_name like '%鼠标%'

测试证明一张千万级别的数据库表进行模糊查询需要20秒以上

当今需求"三高"的需求下,不能接受这样的性能

我们使用ES来优化后同样的查询我们能将效率提高100倍

将大型的查询也能控制在毫秒级别

Elasticsearch查询原理

如果不使用ES让数据库查询,没有索引加持的模糊查询就是全表搜索性能差

但是Elasticsearch可以利用添加数据库完成对数据的分词倒排索引形成索引库

在查询时直接查询索引库,获得符合查询条件的数据信息

docker 部署 elasticsearch + elasticsearch-head + elasticsearch-head 跨域问题 + IK 分词器

0. docker pull 拉取 elasticsearch + elasticsearch-head 镜像

1. 启动 elasticsearch Docker 镜像

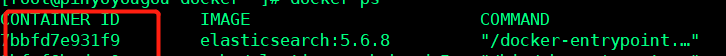

docker run -di --name tensquare_elasticsearch -p 9200:9200 -p 9300:9300 elasticsearch![]()

对应 IP:9200 ---- 反馈下边 json 数据,表示启动成功

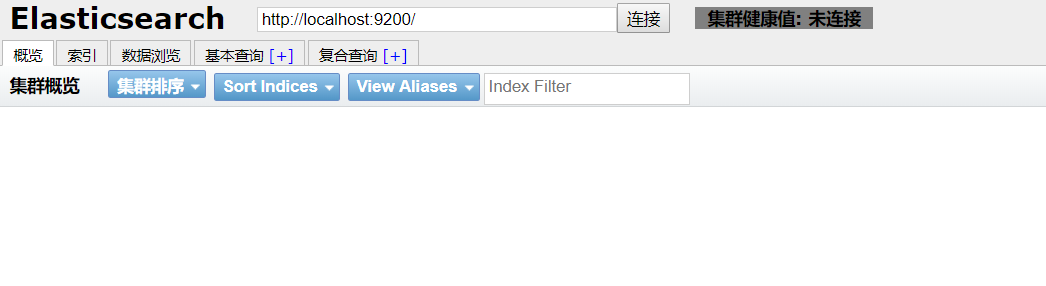

2. 启动 elasticsearch-head 镜像

docker run -d -p 9100:9100 elasticsearch-head![]()

对应 IP:9100 ---- 得到下边页面,即启动成功

3. 解决跨域问题

进入 elasticsearch-head 页面,出现灰色未连接状态 , 即出现跨域问题

1. 根据 docker ps 得到 elasticsearch 的 CONTAINER ID

2. docker exec -it elasticsearch 的 CONTAINER ID /bin/bash 进入容器内

3. cd ./config

4. 修改 elasticsearch.yml 文件

echo "

http.cors.enabled: true

http.cors.allow-origin: ''*''" >> elasticsearch.yml

4. 重启 elasticsearch

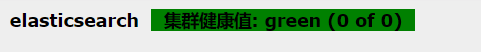

docker restart elasticsearch的CONTAINER ID重新进入 IP:9100 进入 elasticsearch-head, 出现绿色标注,配置成功 !

5. ik 分词器的安装

将在 ik 所在的文件夹下,拷贝到 /usr/share/elasticsearch/plugins --- 注意: elasticsearch 的版本号必须与 ik 分词器的版本号一致

docker cp ik elasticsearch的CONTAINER ID:/usr/share/elasticsearch/plugins

重启elasticsearch

docker restart elasticsearch

未添加ik分词器:http://IP:9200/_analyze?analyzer=chinese&pretty=true&text=我爱中国

添加ik分词器后:http://IP:9200/_analyze?analyzer=ik_smart&pretty=true&text=我爱中国

Elasticsearch CentOS6.5下安装ElasticSearch6.2.4+elasticsearch-head+Kibana

CentOS6.5下安装ElasticSearch6.2.4

(1)配置JDK环境

配置环境变量

export JAVA_HOME="/opt/jdk1.8.0_144"

export PATH="$JAVA_HOME/bin:$PATH"

export CLASSPATH=".:$JAVA_HOME/lib"

(2)安装ElasticSearch6.2.4

下载地址:https://www.elastic.co/cn/downloads/past-releases/elasticsearch-6-2-4

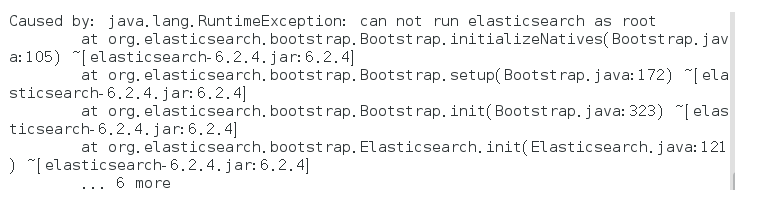

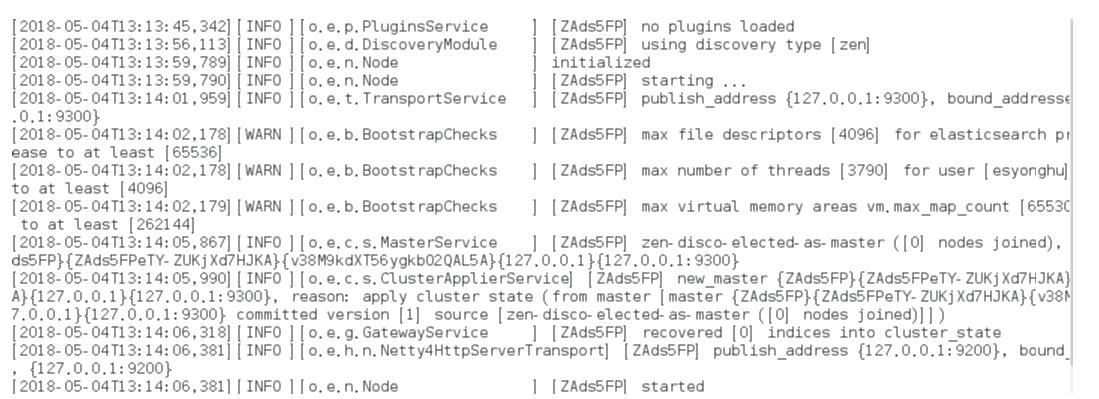

启动报错:

解决方式:

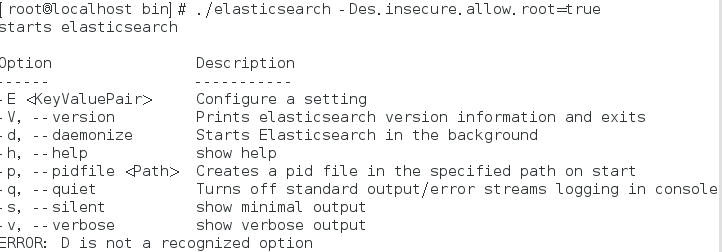

bin/elasticsearch -Des.insecure.allow.root=true

或者修改bin/elasticsearch,加上ES_JAVA_OPTS属性:

ES_JAVA_OPTS="-Des.insecure.allow.root=true"

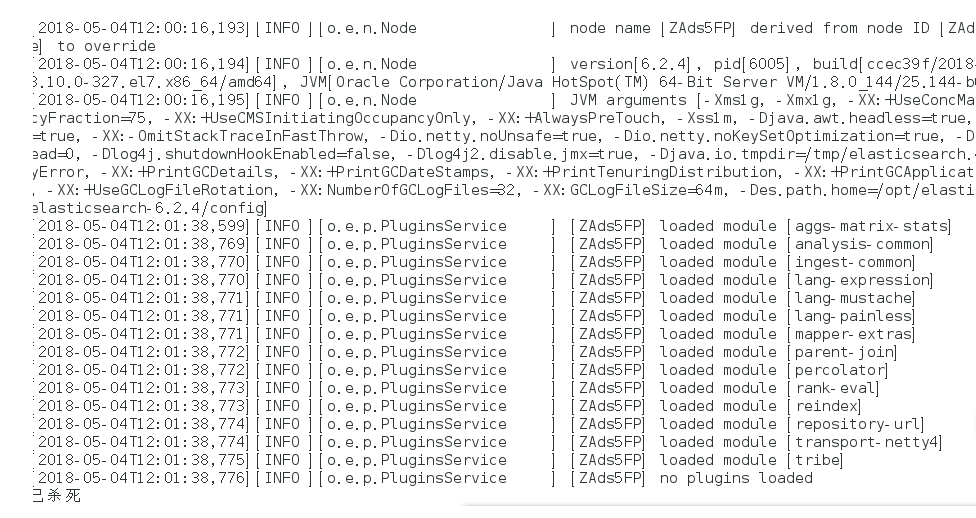

再次启动:

这是出于系统安全考虑设置的条件。由于ElasticSearch可以接收用户输入的脚本并且执行,为了系统安全考 虑,建议创建一个单独的用户用来运行ElasticSearch。

如果没有普通用户就要创建一个普通用户组和普通用户,下面介绍一下怎么创建用户组和普通用户

创建用户组和用户:

groupadd esgroup

useradd esuser -g esgroup -p espassword

更改elasticsearch文件夹及内部文件的所属用户及组:

cd /opt

chown -R esuser:esgroup elasticsearch-6.2.4

切换用户并运行:

su esuser

./bin/elasticsearch

再次启动显示已杀死:

需要调整JVM的内存大小:

vi bin/elasticsearch

ES_JAVA_OPTS="-Xms512m -Xmx512m"

再次启动:启动成功

如果显示如下类似信息:

[INFO ][o.e.c.r.a.DiskThresholdMonitor] [ZAds5FP] low disk watermark [85%] exceeded on [ZAds5FPeTY-ZUKjXd7HJKA][ZAds5FP][/opt/elasticsearch-6.2.4/data/nodes/0] free: 1.2gb[14.2%], replicas will not be assigned to this node

需要清理磁盘空间。

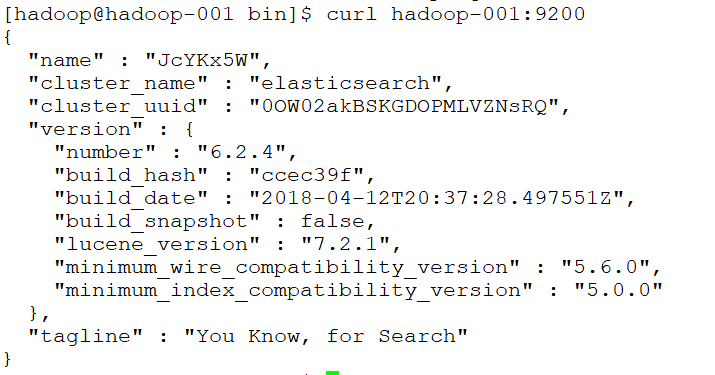

后台运行:./bin/elasticsearch -d

测试连接:curl 127.0.0.1:9200

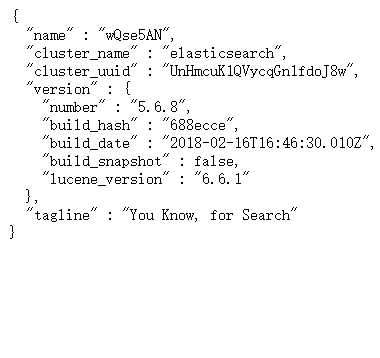

会看到一下JSON数据:

[root@localhost ~]# curl 127.0.0.1:9200

{

"name" : "rBrMTNx",

"cluster_name" : "elasticsearch",

"cluster_uuid" : "-noR5DxFRsyvAFvAzxl07g",

"version" : {

"number" : "5.1.1",

"build_hash" : "5395e21",

"build_date" : "2016-12-06T12:36:15.409Z",

"build_snapshot" : false,

"lucene_version" : "6.3.0"

},

"tagline" : "You Know, for Search"

}

实现远程访问:

需要对config/elasticsearch.yml进行 配置:

network.host: hadoop-001

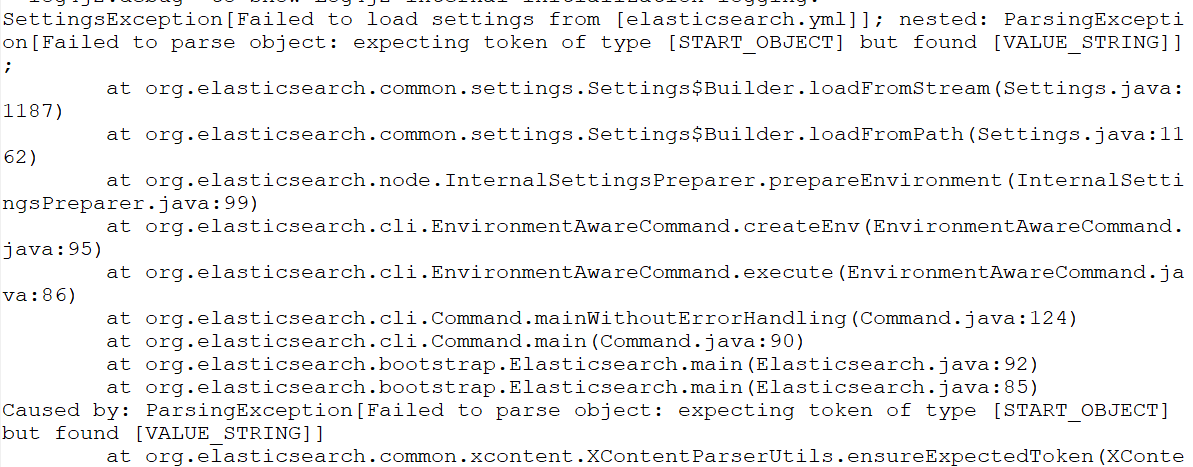

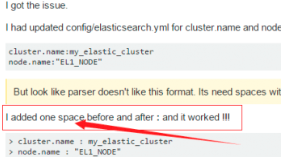

再次启动报错:Failed to load settings from [elasticsearch.yml]

这个错就是参数的冒号前后没有加空格,加了之后就好,我找了好久这个问题;

后来在一个外国网站找到了这句话.

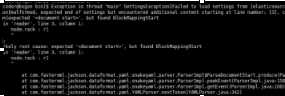

Exception in thread "main" SettingsException[Failed to load settings from [elasticsearch.yml]]; nested: ElasticsearchParseException[malformed, expected end of settings but encountered additional content starting at line number: [3], column number: [1]]; nested: ParserException[expected ''<document start>'', but found BlockMappingStart

in ''reader'', line 3, column 1:

node.rack : r1

^

];

Likely root cause: expected ''<document start>'', but found BlockMappingStart

in ''reader'', line 3, column 1:

node.rack : r1

这个是行的开头没有加空格,fuck!

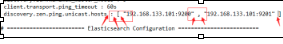

Exception in thread "main" SettingsException[Failed to load settings from [elasticsearch.yml]]; nested: ScannerException[while scanning a simple key

in ''reader'', line 11, column 2:

discovery.zen.ping.unicast.hosts ...

^

参数冒号后加空格,或者是数组中间加空格

例如:

# discovery.zen.minimum_master_nodes: 3

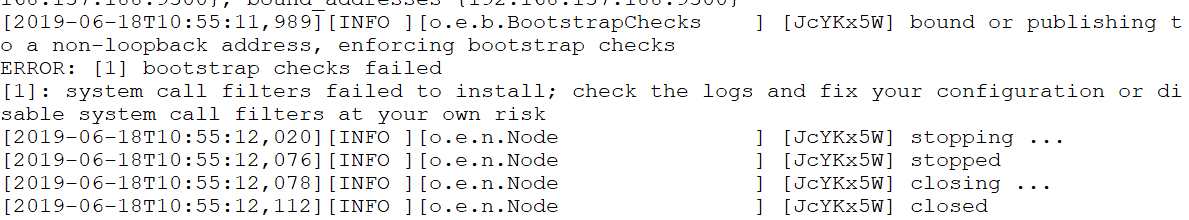

再次启动

还是报错

max file descriptors [4096] for elasticsearch process is too low

处理第一个错误:

vim /etc/security/limits.conf //文件最后加入

esuser soft nofile 65536

esuser hard nofile 65536

esuser soft nproc 4096

esuser hard nproc 4096

处理第二个错误:

进入limits.d目录下修改配置文件。

vim /etc/security/limits.d/20-nproc.conf

修改为 esuser soft nproc 4096

注意重新登录生效!!!!!!!!

处理第三个错误:

vim /etc/sysctl.conf

vm.max_map_count=655360

执行以下命令生效:

sysctl -p

关闭防火墙:systemctl stop firewalld.service

启动又又又报错

system call filters failed to install; check the logs and fix your configuration or disable sys

直接在

config/elasticsearch.yml 末尾加上一句

bootstrap.system_call_filter: false再次启动成功!

安装Head插件

Head是elasticsearch的集群管理工具,可以用于数据的浏览和查询

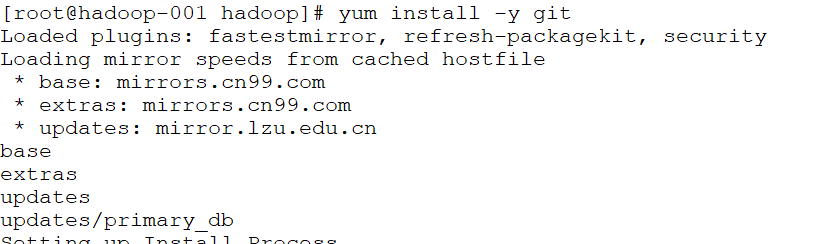

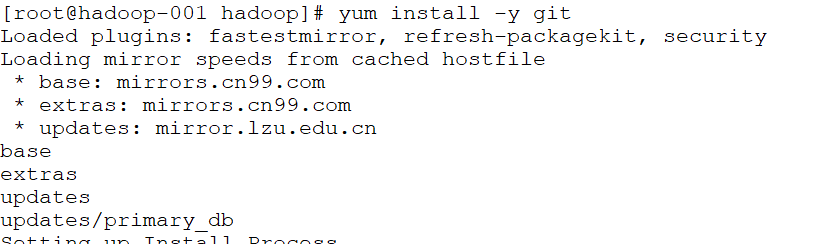

(1)elasticsearch-head是一款开源软件,被托管在github上面,所以如果我们要使用它,必须先安装git,通过git获取elasticsearch-head

(2)运行elasticsearch-head会用到grunt,而grunt需要npm包管理器,所以nodejs是必须要安装的

nodejs和npm安装:

http://blog.java1234.com/blog/articles/354.html

git安装

yum install -y git

(3)elasticsearch5.0之后,elasticsearch-head不做为插件放在其plugins目录下了。

使用git拷贝elasticsearch-head到本地

cd ~

git clone git://github.com/mobz/elasticsearch-head.git

(4)安装elasticsearch-head依赖包

[root@localhost local]# npm install -g grunt-cli

[root@localhost _site]# cd /usr/local/elasticsearch-head/

[root@localhost elasticsearch-head]# cnpm install

(5)修改Gruntfile.js

[root@localhost _site]# cd /usr/local/elasticsearch-head/

[root@localhost elasticsearch-head]# vi Gruntfile.js

在connect-->server-->options下面添加:hostname:’*’,允许所有IP可以访问

(6)修改elasticsearch-head默认连接地址

[root@localhost elasticsearch-head]# cd /usr/local/elasticsearch-head/_site/

[root@localhost _site]# vi app.js

将this.base_uri = this.config.base_uri || this.prefs.get("app-base_uri") || "http://localhost:9200";中的localhost修改成你es的服务器地址

(7)配置elasticsearch允许跨域访问

打开elasticsearch的配置文件elasticsearch.yml,在文件末尾追加下面两行代码即可:

http.cors.enabled: true

http.cors.allow-origin: "*"

(8)打开9100端口

[root@localhost elasticsearch-head]# firewall-cmd --zone=public --add-port=9100/tcp --permanent

重启防火墙

[root@localhost elasticsearch-head]# firewall-cmd --reload

(9)启动elasticsearch

(10)启动elasticsearch-head

[root@localhost _site]# cd ~/elasticsearch-head/

[root@localhost elasticsearch-head]# node_modules/grunt/bin/grunt server 或者 npm run start

(11)访问elasticsearch-head

关闭防火墙:systemctl stop firewalld.service

浏览器输入网址:hadoop-001:9100/

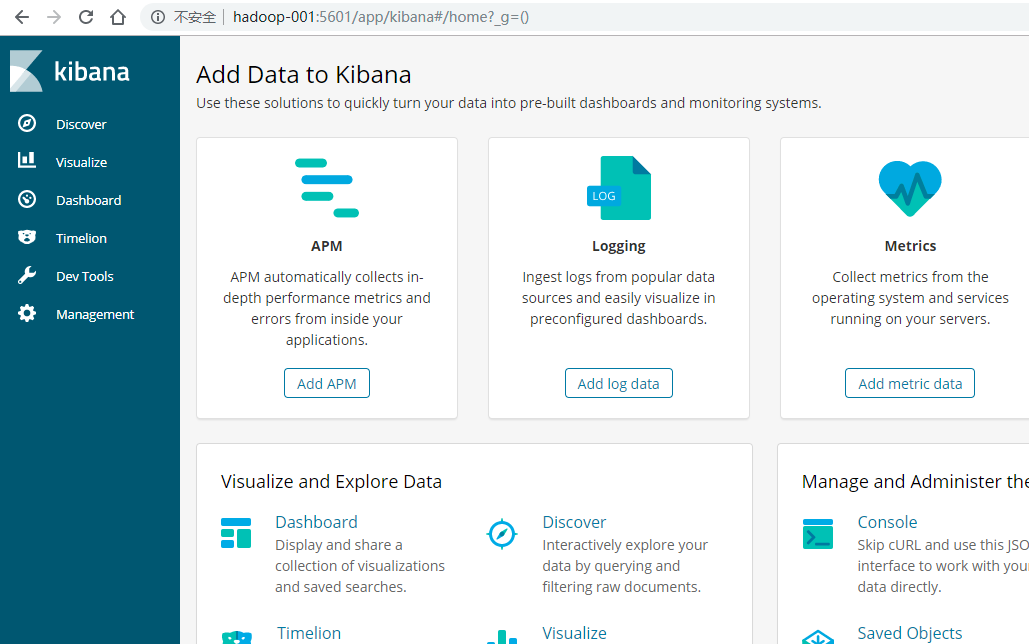

安装Kibana

Kibana是一个针对Elasticsearch的开源分析及可视化平台,使用Kibana可以查询、查看并与存储在ES索引的数据进行交互操作,使用Kibana能执行高级的数据分析,并能以图表、表格和地图的形式查看数据

(1)下载Kibana

https://www.elastic.co/downloads/kibana

(2)把下载好的压缩包拷贝到/soft目录下

(3)解压缩,并把解压后的目录移动到/user/local/kibana

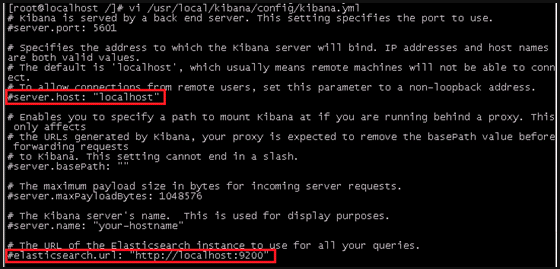

(4)编辑kibana配置文件

[root@localhost /]# vi /usr/local/kibana/config/kibana.yml

将server.host,elasticsearch.url修改成所在服务器的ip地址

server.port: 5601 //监听端口

server.host: "hadoo-001" //监听IP地址,建议内网ip

elasticsearch.url: "http:/hadoo-001" //elasticsearch连接kibana的URL,也可以填写192.168.137.188,因为它们是一个集群

(5)开启5601端口

Kibana的默认端口是5601

开启防火墙:systemctl start firewalld.service

开启5601端口:firewall-cmd --permanent --zone=public --add-port=5601/tcp

重启防火墙:firewall-cmd –reload

(6)启动Kibana

[root@localhost /]# /usr/local/kibana/bin/kibana

浏览器访问:http://192.168.137.188:5601

安装中文分词器

一.离线安装

(1)下载中文分词器

https://github.com/medcl/elasticsearch-analysis-ik

下载elasticsearch-analysis-ik-master.zip

(2)解压elasticsearch-analysis-ik-master.zip

unzip elasticsearch-analysis-ik-master.zip

(3)进入elasticsearch-analysis-ik-master,编译源码

mvn clean install -Dmaven.test.skip=true

(4)在es的plugins文件夹下创建目录ik

(5)将编译后生成的elasticsearch-analysis-ik-版本.zip移动到ik下,并解压

(6)解压后的内容移动到ik目录下

二.在线安装

./elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v6.2.4/elasticsearch-analysis-ik-6.2.4.zip

今天关于elasticsearch(es) 集群恢复触发配置和Local Gateway参数的介绍到此结束,谢谢您的阅读,有关011,elasticsearch--[L13]-- 图解 Elasticsearch 容错机制:master 选举,replica 容错,数据恢复、day81(Sentinel,SpringGateway 网关,csmall项目网关,Elasticsearch概述)、docker 部署 elasticsearch + elasticsearch-head + elasticsearch-head 跨域问题 + IK 分词器、Elasticsearch CentOS6.5下安装ElasticSearch6.2.4+elasticsearch-head+Kibana等更多相关知识的信息可以在本站进行查询。

本文标签: