本篇文章给大家谈谈Python一个妹子要求我重写[::-1],同时本文还将给你拓展ASP.NETMVC要求我重新验证PNG文件,而不是GIF或JPEG、python基础(2):python的安装、第一

本篇文章给大家谈谈Python 一个妹子要求我重写[::-1],同时本文还将给你拓展ASP.NET MVC要求我重新验证PNG文件,而不是GIF或JPEG、python 基础 (2):python 的安装、第一个 python 程序、python 爬取妹子、python 爬虫 下载妹子图片等相关知识,希望对各位有所帮助,不要忘了收藏本站喔。

本文目录一览:- Python 一个妹子要求我重写[::-1]

- ASP.NET MVC要求我重新验证PNG文件,而不是GIF或JPEG

- python 基础 (2):python 的安装、第一个 python 程序

- python 爬取妹子

- python 爬虫 下载妹子图片

![Python 一个妹子要求我重写[::-1] Python 一个妹子要求我重写[::-1]](http://www.gvkun.com/zb_users/upload/2025/02/ac8e39b7-5acc-44c6-aa47-66b85327df241740027620890.jpg)

Python 一个妹子要求我重写[::-1]

代码如下:

# -*- coding: UTF-8 -*-

#重写[::1]实现!

list_result = []

l_string = ''''

def reserved(text):

global l_string

for string in text:

list_result.append(string)

x = len(list_result)

while x > 0:

x -=1

l_string += list_result[x]

print l_string

if __name__ == ''__main__'':

reserved("I Like Python!")

ASP.NET MVC要求我重新验证PNG文件,而不是GIF或JPEG

我的路线设置如下:

public static void RegisterRoutesTo(RouteCollection routes) {

routes.IgnoreRoute("{resource}.axd/{*pathInfo}");

routes.IgnoreRoute("elmah.axd");

routes.IgnoreRoute("{*favicon}",new { favicon = @"(.*/)?favicon.ico(/.*)?" });

routes.MapRoute(

"Default","",new { controller = "Home",action = "Index"} // Parameter defaults

);

routes.MapRoute(

"Session","{action}",new { controller = "Session" },new { action = "(login|logout|register)" }

);

routes.MapRoute("CatchAll","{*catchall}",new { controller = "Error",action = "NotFound" });

}

在我的CSS中,我有这个:

.iconLocationLarge { background-image: url(../images/icon_vcarea_48x48.png) !important;}

.iconVCLarge { background-image: url(../images/tb-btn-sprite.gif) !important;}

问题是如果我使用PNG而不是GIF,我会被提示再次进行身份验证.为什么?

解决方法

假设这是IIS6,从管理工具打开IIS管理器,右键单击本地计算机节点,单击MIME类型,检查PNG是否注册为“image / png”.您还可以在单个网站级别配置此项.

确保没有其他过滤器可能导致问题,例如UrlScan ISAPI过滤器.

python 基础 (2):python 的安装、第一个 python 程序

1. 第一个 python 程序

1.1 python 的安装

自己百度,这是自学最基本的,安装一路确定即可,记得 path 下打钩。

1.2 python 的编写

python 程序有两种编写方式:

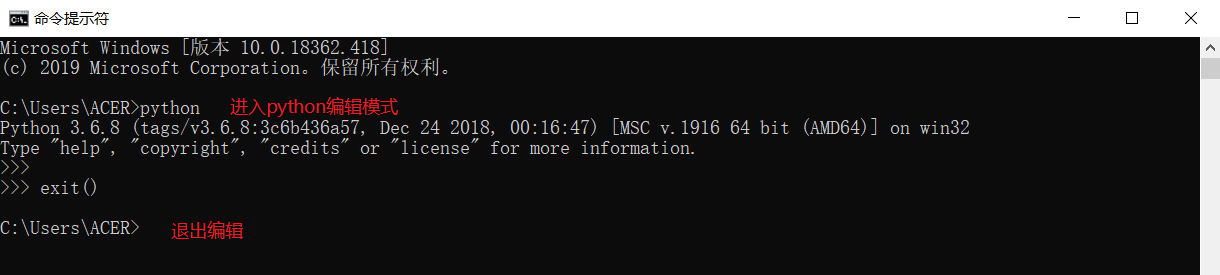

1. 进入 cmd 控制台,输入 python 进入编辑模式。这时候我们可以直接编写 python 程序

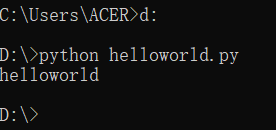

2. 也可以在.py 文件中编写 python 代码。通过 python 命令来执行 python 代码

注意:python2 默认的编码是 ASCII 码编码,处理不了中文,需要替换成 utf-8 编码。python3 默认的编码为 unicode,utf-8 可以看做是 unicode 的一个扩展集。

python2 可以在.py 中第一行加入

# -*- encoding:utf-8 -*-1.2.1 cmd 方式编写

进入和退出:

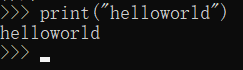

helloworld 案例:

1.2.2 .py 文件方式编写

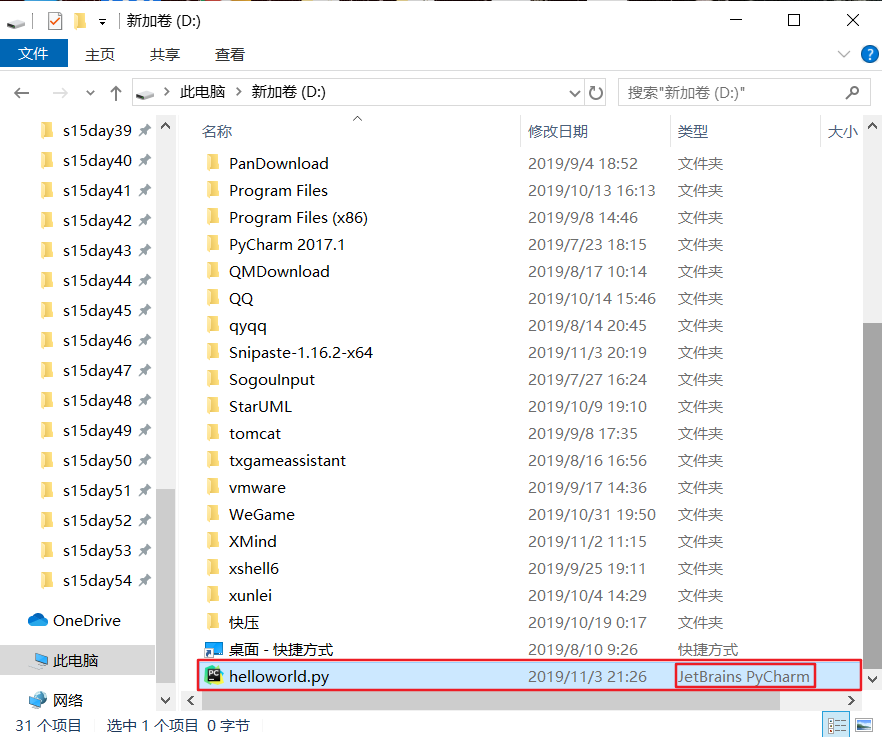

1. 在 D 盘下创建一个 helloworld.py 的文件 (注意文件类型,图标不同是因为我安装了 pycharm 软件)

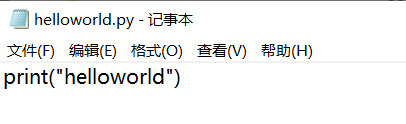

2. 进入 helloworld.py, 输入内容

3.cmd 进入 D 盘,使用 python 文件名 来运行文件

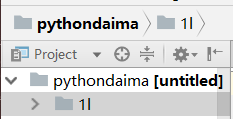

1.2.3 在 pycharm 软件下运行

pycharm 软件的下载和安装、激活码、使用说明都可以在百度上查询到,此处就不描述了。

右键 -->new-->python package (创建包):

在包目录下创建 python 文件:

点击新建的 python 文件,输入代码:

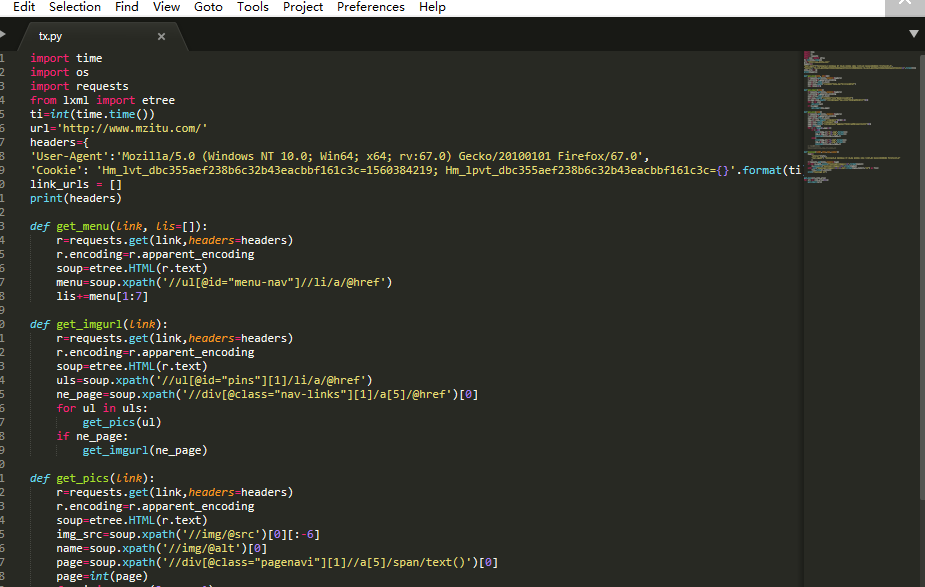

python 爬取妹子

爬取妹子图片

2019-06-13

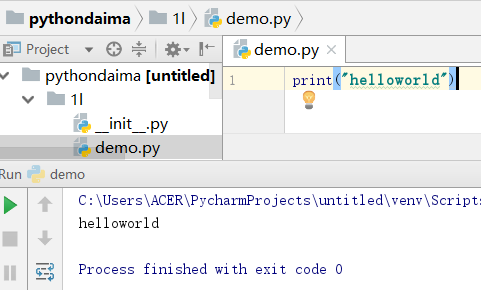

环境WIN10 1903 python 3.7.3

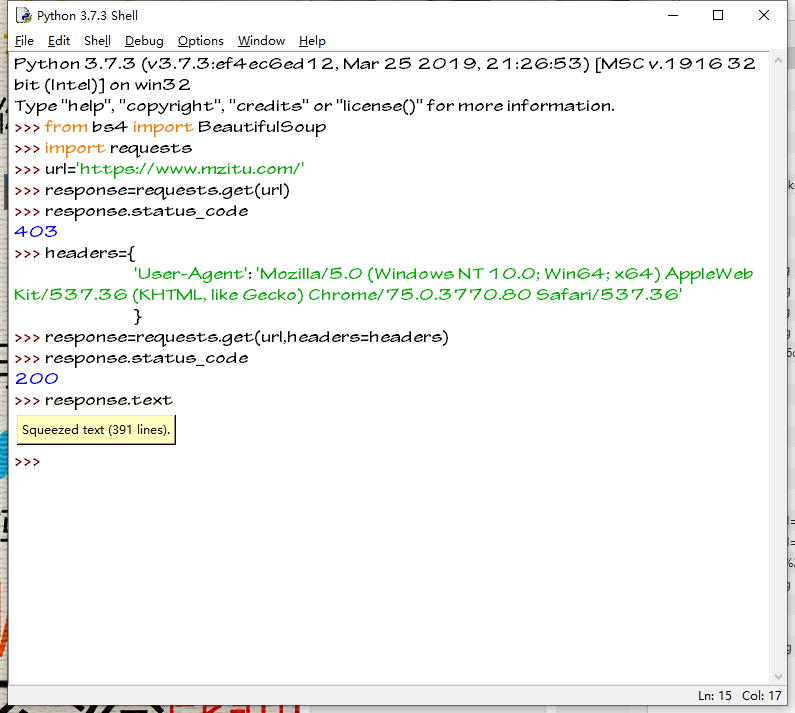

个人习惯先在IDLE中进行调试

import requests

from bs4 import BeautifulSoup

url=''https://www.mzitu.com/''

response=requests.get(url=url)

print(response.status_code)

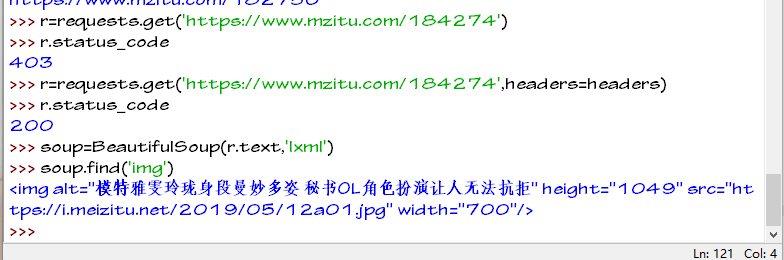

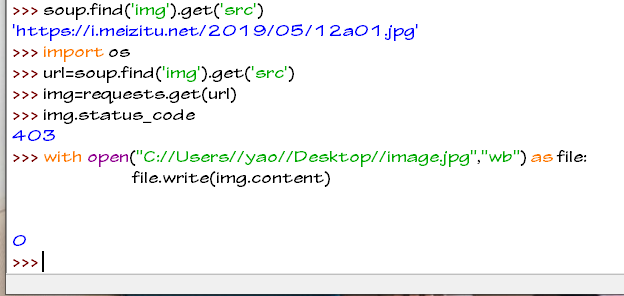

403是返回的状态码

403错误,表示资源不可用。服务器理解客户的请求,但拒绝处理它,通常由于服务器上文件或目录的权限设置导致的WEB访问错误。

该网站有反爬措施

我们先试一下伪造浏览器

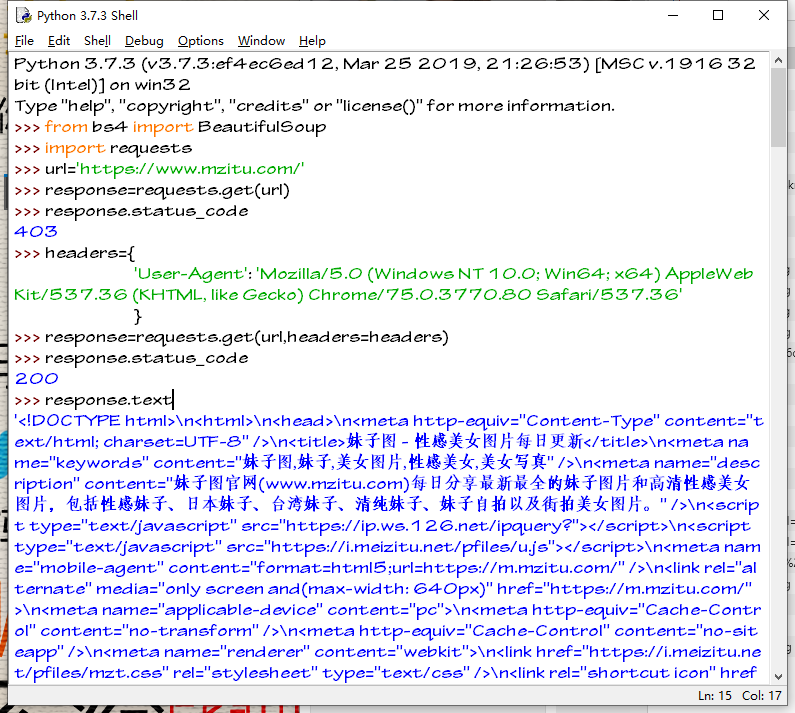

打开google看一下我们发送的请求

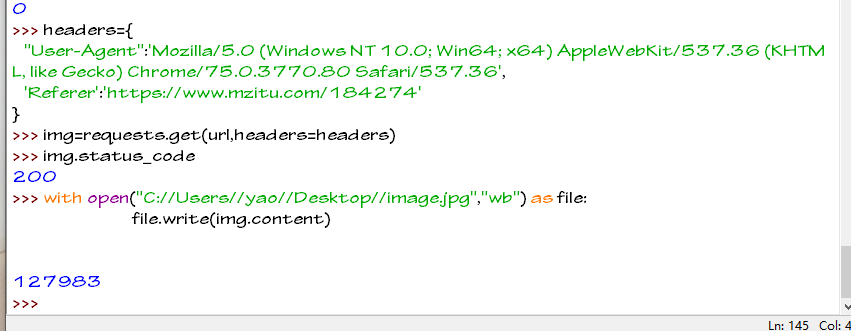

我们构造headers

headers={

''User-Agent'':''Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36(KHTML, like Gecko) Chrome/75.0.3770.80 Safari/537.36''

}

返回的状态码为 200

说明伪造浏览器成功

使用response.text查看返回的内容

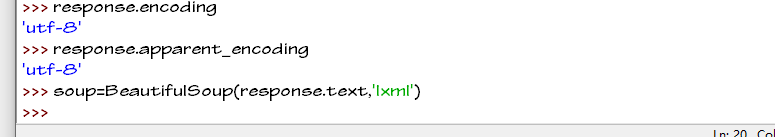

我习惯调试使用bs4库BeautifulSoup类

正式写脚本我习惯用lxml库的etree类

查看网页编码

解析判断的编码与备用编码相同 我们可以忽略

开始进入解析部分

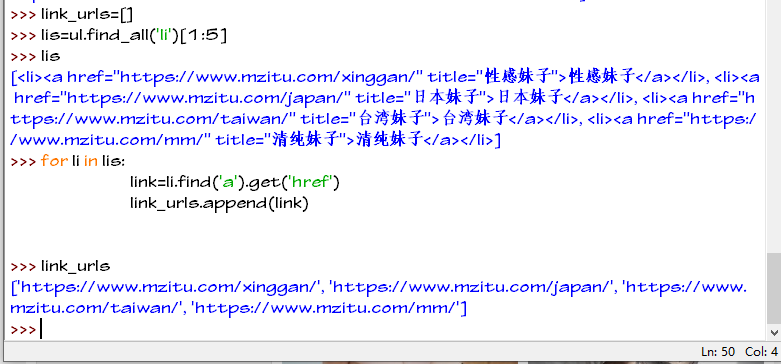

我们选取网页格式相同的4个部分进行爬取

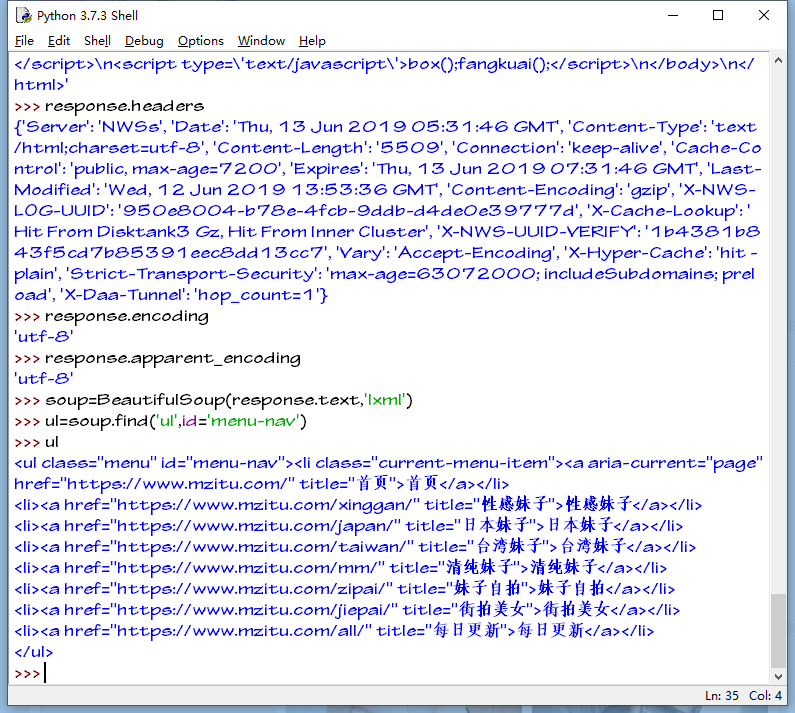

菜单栏为<ul></ul>标签而且id=''menu-nav''开始写代码

首先我们先创建BeautifulSoup对象

关于BeautifulSoup的使用 查看官方文档 https://www.crummy.com/software/BeautifulSoup/bs3/documentation.zh.html

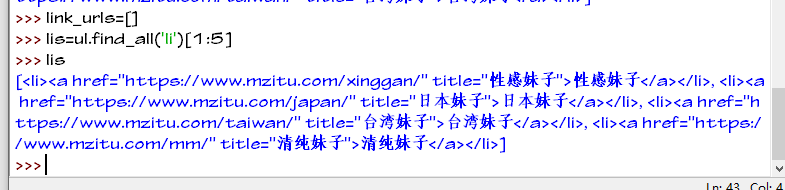

选取我们需要的三个li标签加入我们创建的link_urls列表中

现在我们要爬取的三个美女类型的链接已经保存到link_urls列表中了

我们以第一类型的性感美女进行爬取

打开这个网页

我们分析这个网页会发现

总共有27个图片缩略图

其中有三个是广告

提取数据的时候要对广告进行清除

查看源代码

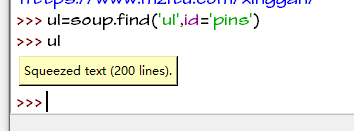

图片在<ul>标签里面且id=''pins''

找到这个ul标签之后

我们继续提取其中的li标签

由于广告的标签含有class属性我们提取li标签已经过滤了三个广告

所以长度为24

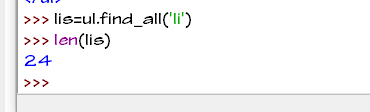

下一步获取图片的该类图片的地址 属性为href

一个图片是一个<li>标签

图片的链接到手 现在的链接只是我们要爬取的图片的地址 并不是图片的链接

现在我们进入图片的提取部分

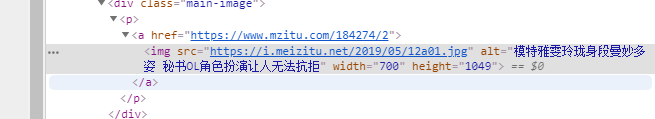

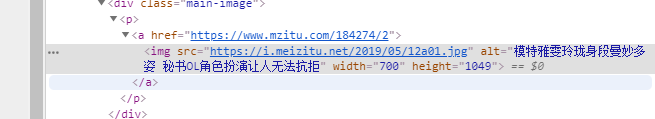

我们以这个链接 https://www.mzitu.com/184274 进行分析

我们要的图片链接在这里

获取页面还是要通过伪造浏览器的方式

下载页面完成我们去获得图片的链接

方法与前面类似

网页中第一个img标签就是我们要的图片

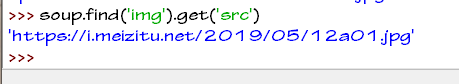

获取到图片的地址 地址在img标签的src属性中我们提取出来

使用requests去下载它

我们使用requests下载时候会发现下载失败

文件写入为0

我们继续构造headers来成功下载图片

headers={

"User-Agent":''Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.80 Safari/537.36'',

''Referer'':''https://www.mzitu.com/184274''

}

# 这里的Referer是你跳转到这个图片的上一个地址 这也是一个反爬小技巧

图片下载成功

img是requests返回内容

由于图片是二进制文件我们用"wb"方式打开写入文件

保存为jpg这样图片就写入成功了

视频 音频也可以这样下载

打开我们下载的图片

成功下载

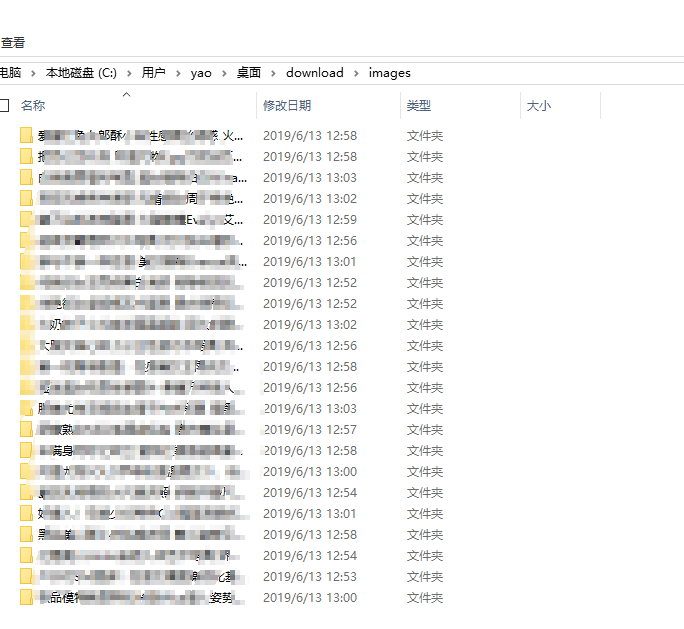

爬取整个类型的图片我们只需要构造几个函数对url进行解析就好

以下笔者的思路

1 找到一个图片的地址我们可以提取页面的下一页的链接然后就是递归调用函数 进行爬取

2 通过查看图片的url我们发现图片是有规律的

https://i.meizitu.net/2019/05/12a02.jpg

https://i.meizitu.net/2019/05/12a03.jpg

...................

最后一张图片就是

https://i.meizitu.net/2019/05/12a50.jpg

这样就能爬取这个系列的图片了

python 爬虫 下载妹子图片

下面是小编 jb51.cc 通过网络收集整理的代码片段。

小编小编现在分享给大家,也给大家做个参考。

#coding:utf-8

import requests

from bs4 import BeautifulSoup

import re

DownPath = "/jiaoben/python/meizitu/pic/"

import urllib

head = {'User-Agent':'Mozilla/5.0 (Windows; U; Windows NT 6.1; en-US; rv:1.9.1.6) Gecko/20091201 Firefox/3.5.6'}

TimeOut = 5

PhotoName = 0

c = '.jpeg'

PWD="/jiaoben/python/meizitu/pic/"

for x in range(1,4):

site = "http://www.meizitu.com/a/qingchun_3_%d.html" %x

Page = requests.session().get(site,headers=head,timeout=TimeOut)

Coding = (Page.encoding)

Content = Page.content#.decode(Coding).encode('utf-8')

ContentSoup = BeautifulSoup(Content)

jpg = ContentSoup.find_all('img',{'class':'scrollLoading'})

for photo in jpg:

PhotoAdd = photo.get('data-original')

PhotoName +=1

Name = (str(PhotoName)+c)

r = requests.get(PhotoAdd,stream=True)

with open(PWD+Name,'wb') as fd:

for chunk in r.iter_content():

fd.write(chunk)

print ("You have down %d photos" %PhotoName)

以上是小编(jb51.cc)为你收集整理的全部代码内容,希望文章能够帮你解决所遇到的程序开发问题。

如果觉得小编网站内容还不错,欢迎将小编网站推荐给程序员好友。

我们今天的关于Python 一个妹子要求我重写[::-1]的分享已经告一段落,感谢您的关注,如果您想了解更多关于ASP.NET MVC要求我重新验证PNG文件,而不是GIF或JPEG、python 基础 (2):python 的安装、第一个 python 程序、python 爬取妹子、python 爬虫 下载妹子图片的相关信息,请在本站查询。

本文标签:

![[转帖]Ubuntu 安装 Wine方法(ubuntu如何安装wine)](https://www.gvkun.com/zb_users/cache/thumbs/4c83df0e2303284d68480d1b1378581d-180-120-1.jpg)