这篇文章主要围绕微信版大语言模型来了:跨时空对话李白、教你高情商说话,在线可玩展开,旨在为您提供一份详细的参考资料。我们将全面介绍微信版大语言模型来了:跨时空对话李白、教你高情商说话,在线可玩,同时也

这篇文章主要围绕微信版大语言模型来了:跨时空对话李白、教你高情商说话,在线可玩展开,旨在为您提供一份详细的参考资料。我们将全面介绍微信版大语言模型来了:跨时空对话李白、教你高情商说话,在线可玩,同时也会为您带来(慕FX)LLM大语言模型算法特训,带你转型AI大语言模型算法工程师、01-大语言模型发展、Chatopera 云服务支持大语言模型对话(LLM),定制您的聊天机器人、DB-GPT —— 数据库大语言模型的实用方法。

本文目录一览:- 微信版大语言模型来了:跨时空对话李白、教你高情商说话,在线可玩

- (慕FX)LLM大语言模型算法特训,带你转型AI大语言模型算法工程师

- 01-大语言模型发展

- Chatopera 云服务支持大语言模型对话(LLM),定制您的聊天机器人

- DB-GPT —— 数据库大语言模型

微信版大语言模型来了:跨时空对话李白、教你高情商说话,在线可玩

鱼羊 梦晨 发自 凹非寺

量子位 | 公众号 QbitAI

大规模语言模型,微信版,来了!

并且甫一登场,就没藏着掖着:

论文、API接口、在线试玩网站……一条龙全都齐备。

续写文本、阅读理解等常规任务就不说了,这个名叫WeLM的AI,竟然直接让我和李白跨时空聊起了杜甫:

我:现在有一首关于你的歌,其中一句歌词是「要是能重来,我要选李白」,请问你自己有什么看法?

李白:我要选杜甫。

这还不算完,WeLM甚至还治好了我不会聊天的毛病,分分钟教会我如何高情商说话。

这么一个AI,参数量不算大,目前处于百亿水平。

但值得关注的是,实验结果显示,它在18个中文语言任务里,效果堪比参数量是其25倍的模型。

是不是有点手痒想上手一试了?先奉上链接,咱们再仔细说说,这波微信是怎么做到的。

体验链接:https://welm.weixin.qq.com/docs/playground/

API接口:https://welm.weixin.qq.com/docs/api/

论文地址:https://arxiv.org/abs/2209.10372

「学富五车」的大模型

微信语言大模型WeLM,全名Well-Read Language Model,也就是「学富五车的语言模型」。在翻译任务上,WeLM不光可以做到基本的,甚至三语夹杂也难不倒它。

在文本续写任务上,只需给出开头就能生成适应不同风格的文本。

这种多语言、多任务能力是怎么做到的?

其实WeLM与著名的GPT-3是同类,都是自回归解码器结构,微信团队选择这种结构就是看中其在海量数据中掌握无穷范式的能力。

在具体实现方法上,WeLM还有两项特色。

一是采用RoPE相对位置编码,与传统的固定位置编码相比能更好处理长文本,比如理解整篇文章甚至整本书。

二是使用62k个token的SentencePiece并保留其中的空格和Tab,这样更有利于下游任务。

使用这些方法,WeLM总共设计了从13亿到100亿参数的三个版本,可按需调用。

其中100亿参数的满血版WeLM在14项中文任务中整体表现超过同大小的模型,甚至在零样本任务上超过比它大25倍的模型。

这其中最大的秘诀就是精心准备的高质量训练数据上充分训练,也就是「学富五车」的含义所在。

高质量训练数据包括从Common Crawl下载的近两年中文网页、大量书籍、新闻、论坛数据和学术论文。

收集到的数据总量超过10TB,其中包含750G英文数据,中文中夹杂的英日韩语为了语义连贯也全部保留。

不过这还不算完,需要经过清洗、去重等一系列步骤才能算得上是高质量数据。

首先是去除噪声和脏数据,结合使用规则和模型检测后,超过87%的数据被过滤。

再利用SimHash算法去重,进一步过滤掉40%的数据。

接下来要去除一切和测评相关的数据,保证公平性,以 17-gram 为检测重复粒度再次过滤了0.15%的数据。

一系列处理后留下的数据量为262B tokens,最后再对这些数据进行不同比重的采样,使数据平滑分布在各个话题上。

对于预训练,团队认为当今多数大模型的训练都不够充分,WeLM 100亿参数版的训练量基本与1750亿的GPT-3相当(300B tokens),在128张A100上训练用了大概24天时间。

为了保证训练效率,WeLM在训练过程中还使用了完全可原地复现的形式,不管发生任何问题都能从最近的checkpoint恢复。

自1750亿参数的GPT-3之后,语言模型规模越来越大,到今年谷歌的PaLM已经达到5400亿,中文大模型同样有这个趋势。

可以看出微信团队选择了另一条路线,以高质量训练数据和高效训练做到「四两拨千斤」的效果。

到这一步WeLM已经有了不错的表现,不过接下来这个步骤再次将其零样本泛化能力提到新的高度。

研究团队针对76个数据集各人工撰写10-20个Prompt,将原任务中的文本关系的标签和输入信息转化成流畅通顺的自然语言形式,更符合自回归语言模型的训练形式。

使用这些Prompt对模型微调后,相当于让模型学会了面对多样的Prompt该做什么。如果遇到相似Prompt形式的全新任务,也可以有更稳定的表现。

实验证明,在全量数据上微调后的模型在新的NLP任务上具备更优秀的零样本迁移能力,同时也使得微调变为一项一劳永逸的工作。

最后,研究团队还测试了WeLM的三个额外能力。

通过提供示例,WeLM可以对自己的决策作出解释,不过这种能力不太稳定,还需要进一步探索。

通过简单提问,WeLM可以对结果进行自我纠正和检查能力,为后续提高性能提供了可能方向。

WeLM还表现出一定的记忆能力,如果输入内容完美匹配前文,即使内容很长、出现频次很低,模型依然可以准确的生成剩下的部分。

最后再来总结一下,WeLM精通中文的同时掌握英日韩等多种外语、可以通过少样本或零样本学习执行全新任务,同时以合理尺寸做到与25倍参数量的模型相媲美使用成本较低,总之就是奔着实用性和大规模落地去的。

同步开放在线体验与API,也是希望有想法的开发者能方便的用起来,让WeLM大模型真正实用的工具。

WeLM怎么用

具体来说,WeLM线上Demo目前释出的功能包括:对话-采访、阅读理解、翻译、改写、续写以及自由任务。

在正式开始跟WeLM玩耍之前,记得要先给模型扔一段简单的「范文」,也就是「prompt」。

在线网站会给出一些默认的prompt,你也可以自行修改设计。需要遵循的设计原则是:

第一,描述清楚;第二,例子具备代表性(多个例子更好)。

以文本分类任务为例,prompt应该长这样:

其中的技巧包括,首先,把分类任务用自然语言清晰地表达出来,在上面这个示例中,「微博」即为输入,「类别」即为输出。

其次,在第一句的指令型描述中,需要把可能的分类结果都列出来。

最后,如果效果不佳,可以尝试加入更多例子,让WeLM更清楚你到底想要做怎样的任务。

另外,正如前文所说,WeLM拥有零样本学习能力。

所以直接把它当作问答搜索引擎来用,也不是不行(手动狗头)。

如果你还想得到更多样化的生成结果,token数量、temperature等参数均可调整。

更重要的一点是,WeLM已开放API接口 。也就是说,如果身为开发者的你想在自己的App里用上这个大模型,填写调查问卷注册即可。

One More Thing

说起来,这样的大模型要是真的落地应用了,妈妈岂不是再也不用担心我因为不会聊天而母胎solo ?

比如说……

你还有什么有趣的脑洞?大胆招呼起来~

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态

(慕FX)LLM大语言模型算法特训,带你转型AI大语言模型算法工程师

LLM大语言模型:引领自然语言处理的新纪元

夏载:百度网盘

在人工智能和机器学习领域,大语言模型(Large Language Model,简称LLM)的崛起标志着自然语言处理(NLP)技术的一大飞跃。LLM不仅为我们带来了更智能、更人性化的交互体验,还极大地拓宽了人工智能在文本生成、问答系统、对话机器人等方面的应用边界。

LLM的核心在于其庞大的模型规模和强大的学习能力。通过深度学习技术,LLM能够处理海量的文本数据,从中学习语言的规则和模式。这使得LLM能够理解和生成复杂的语言结构,甚至展现出一定的创意和逻辑性。与此同时,随着计算能力的提升和算法的优化,LLM的规模和性能也在不断提升,进一步推动了NLP技术的发展。

在实际应用中,LLM展现出了巨大的潜力。在文本生成方面,LLM可以生成高质量的文章、新闻、诗歌等,甚至能够根据用户的输入进行个性化的内容创作。在问答系统和对话机器人方面,LLM能够更准确地理解用户的意图,提供更精准、更自然的回答和交互体验。此外,LLM还可以应用于机器翻译、情感分析、文本摘要等多个领域,为人们的生活和工作带来便利。

然而,LLM的发展也面临着一些挑战和问题。首先,LLM的训练需要大量的数据和计算资源,这使得其研发和部署成本较高。其次,由于LLM的复杂性,其可解释性和可控性仍然是一个难题。此外,随着LLM的广泛应用,如何保护用户隐私和数据安全也成为了一个亟待解决的问题。

尽管如此,LLM的未来依然充满了无限可能。随着技术的不断进步和应用场景的不断拓展,我们有理由相信,LLM将在更多领域发挥重要作用,为我们的生活带来更多的惊喜和便利。同时,我们也需要关注并解决LLM发展过程中遇到的问题和挑战,确保其能够健康、可持续地发展。

总之,LLM大语言模型作为自然语言处理领域的一项重要技术,正在引领着人工智能的新纪元。我们有理由期待它在未来能够为我们带来更多的创新和价值。

01-大语言模型发展

AI大模型的相关的一些基础知识,一些背景和基础知识。

多模型强应用AI 2.0时代应用开发者的机会。

0 大纲

- AI产业的拆解和常见名词

- 应用级开发者,在目前这样一个大背景下的一个职业上面的一些机会

- 实战部分的,做这个agent,即所谓智能体的这么一个虚拟项目,项目需求分析、技术选型等

1 大语言模型发展

LLM,Large Language Model,大语言模型。为什么叫2.0?因为在大语言模型,也就是LLM出现之前,我们把它归结为1.0时代。那么1.0时代主要的是NLP(自然语言处理)的各类工程,它其实都是一个特点,就是说通用性比较差。那么整个AI领域的终极的圣杯,或者说将来它的一个终极的一个希望做到的,是AGI(Artificial General Intelligence,人工通用智能)。1.0可能是一个单任务的这么一个AI。比如深蓝战胜象棋冠军,他只会下象棋,而且他的下象棋是学习了很多的这个象棋的这个国际象棋的这个套路,他只会干这一个事情,而且你问他别的事情他肯定不知道。

2 LLM的特点

大语言模型的特点是啥?大语言模型,它就是说可以像语言一样跟我们交互,那么通过语言,它其实可以扩展到很多的场景。那么未来呢,可能会从依据大语言这种方式,我们可能会发展出来真的发展出来AGI,所谓的通用智能,也就是跟我们人类一样拥有智慧的这样的一个智能体。那好,那我们1.0我们AI 1.0我们就不做介绍了,那里面其实有很多NLP的相关的东西。

2.0开始介绍,技术层面基本上是一个从点到面的一个过程。那么最早出现的一个技术,是词向量技术,把自然语言的词语,使用向量来表示。向量是一个数学概念,比如猫,这个词在向量空间里面,它可能就表示成这样一个坐标位置。狗可能就跟它有所区别。牛又不一样。所以可理解为,每一个词,它在向量空间里面都有一个唯一坐标,然后就可构成这样的一个词语字典。然后使用这种one-hot的方式来表示,如苹果标注成101这样的坐标。把自然语言,通过数学语言去给它描述出来,而且它是一个坐标,可精准找到它位置。

3 大模型的不足和解决方案

但有问题,它没有办法表达词语和词语之间的这个关系。比如猫1这样一个坐标,和狗这样01一个坐标,之间什么关系呢?不知道的。

第二就是效率不是很高。

后面发展中,在这个词向量的基础上,出现

4 词嵌入(embedding)

也继续叫词向量也可以,就是对语言模型进行预训练。我们通过大量现有文章资料,让我们的这前面这些词向量,它具备语言信息。那通过了一些训练的预训练之后的这个词向量,它在这个向量空间上,它就带上了一些额外的信息,它就会有效提升我们模型的效果。而且在后续的其他任务中间,去做一个迁移。那么这个就是大语言模型的预训练的这个,一个初始的一个原型。

比如猫、狗,通过坐标标注,让它有这种低维向量的这种这种表示。还可有这样语义相似的一个向量空间相近,好比我们认为,比如说猫和狗,通过我们的预训练的这些大量的文章,资料,我们发现猫和狗都同属于宠物。那么有可能这两个坐标点,在向量空间里就是比较接近。比如说我们找宠物的时候,那么在这个向量空间里面,猫和狗就是在宠物这个向量域里面。牛和羊,都属于我们的常用的肉吃的家畜,那可能就是在那个向量域里面。所以呢,我们可以看到词向量,它就是一个地位向量表示,再一个是语义相似的向量空间,相近的这么一个特性。还有一个,它可以迁移学习,把这个任务,迁移到其他任务里面去。深蓝的下象棋例子,就可以把它的技能去迁移啦。

在词嵌入之后出现

5 巨向量和全文向量

根据这个前文信息,去分析下文或根据本文翻译成另一种语言。那么它代表的呢,是一些模型,如:

- RNN(Recurrent Neural Network,循环神经网络)

- LSTM(Long Short-Term Memory,长短期记忆网络)

它可有效处理这种时序性的,序列数据。"What time is it?",训练时,它是一层一层的,它第一层这个神经网络,可能先看到"What",然后"time","is","it",看到最后的问号。它会通过这样的一个顺序,去处理这样的一个语句,去做一个上下文的一个理解。它还可以做到一些短时记忆和选择性的遗忘,就是RNN和LSTM,那么它主要应用在像文本生成啊,语音识别啊,图像描述等等。这个时候就是比如说类似RNN和LSTM这样的模型出现的时候呢,它其实已经可以做到我们常见的一些AI识别。

再往后就到理解上下文,就是全文的上下文,如"买什么 什么is"这个这个模式理解上下文,这个模式代表作是类似比如说这个BERT这样大模型。到这阶段,已经可完成类似完形填空任务。那它就是根据上下文理解当前的代词,比如说男他女她动物它是什么,完成这个完形填空。那么这个时候就属于所谓的真域训练模型时代开启。

特点

支持并行训练,如说CNN(Convolutional Neural Network,卷积神经网络)这个模型比,就比如说这个"What time is it",只能一层一层处理,不支持并行训练。必须完成这个事情之后再做下一个事情。

所以呢,它替代RNN和CNN这样神经网络,更强大,可以实现一些类似语义识别。

最后就是OpenAI这GPT(Generative Pre-trained Transformer)出现,这个模型出现为代表,我们就正式进入了这种超大模型和模型统一的时代。从谷歌T5(Text-to-Text Transfer Transformer)这个模型开始的时候,它是引入了的这样的一个模式来训练模型。也就是说,它是把提示词告诉模型,然后把答案训练出来,然后不停的用这样的模式来训练模型。那么当我们在问模型这些问题的时候,其实也是通过,通过提示词,通过prompt的方式来引导它。所以到这个时代的时候呢,那我们以chatgpt为代表,我们发现它的效果非常惊艳。最新的成果就是说,我们的大模型已经支持了多模态,OpenAI开启的这个大模型时代呢,它其实是把这个,一种基于的这种训练模型这种方式提了出来。

所以我们为什么开始一讲就是说,它整个的大模型的发展,可以说是从一个从点到面的这么一个发展过程。大家知道理解就是它最核心,其实最早的是基于这个词向量的这么一个技术。那么通过这个不断的发展到神经网络,到这种单线的,到并行训练,最后直到这样的一个大规模超大规模的这样一个训练集,实现了这么一个大语言的一个模型的发展。

关注我,紧跟本系列专栏文章,咱们下篇再续!

各大技术社区头部专家博主。具有丰富的引领团队经验,深厚业务架构和解决方案的积累。

负责:

- 中央/分销预订系统性能优化

- 活动&优惠券等营销中台建设

- 交易平台及数据中台等架构和开发设计

车联网核心平台-物联网连接平台、大数据平台架构设计及优化

目前主攻降低软件复杂性设计、构建高可用系统方向。

参考:

编程严选网

本文由博客一文多发平台 OpenWrite 发布!

Chatopera 云服务支持大语言模型对话(LLM),定制您的聊天机器人

2024 年,Chatopera 云服务继续不断完善,为开发者提供最好的定制聊天机器人的工具。在过去的一年,用户们反映最多的建议是 Chatopera 云服务内置大语言模型的对话,今天 Chatopera 云服务完成了产品升级,满足了这个诉求。

大语言模型对话的应用场景

大语言模型通过对海量语料进行机器学习,可以回答很多种类的问题,以下列举 3 点:

- 回答事实性问题,比如 “珠穆朗玛峰的海拔是多少?”

- 回答生活、天气、出行信息,比如 “今天北京的天气怎么样?”,“北京四环现在拥堵吗”,“东坡肘子的做法”

- 艺术创作,比如 “作一首七言绝句”

当您需要机器人回答上述类型的问题时,开启 Chatopera 机器人的【大语言模型(LLM)】。

多轮对话的检索

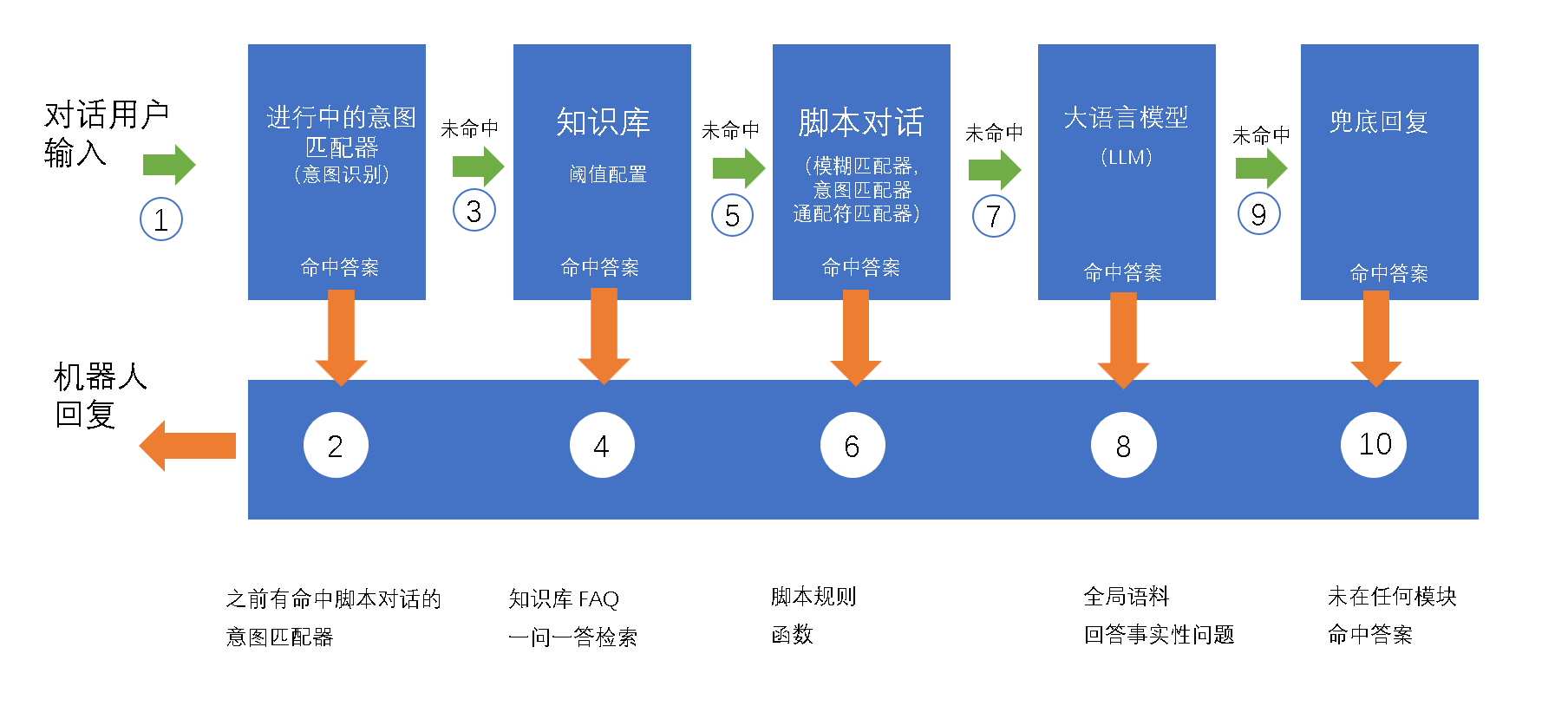

支持大语言模型后,Chatopera 云服务中,多轮对话的检索机制得到了完善,大语言模型和意图识别、知识库、兜底回复之间的优先级是什么样的呢?作为聊天机器人开发者,您需要特别注意现在的运行算法。

在上图中,可见优先级最高的是【运行中的意图识别对话】,然后是知识库,接下来是脚本对话,如果这几个技能模块没有命中答案,才会进入到【大语言模型(LLM)】中。

更多介绍和使用说明,点击【阅读更多】。

DB-GPT —— 数据库大语言模型

DB-GPT 是一个开源的以数据库为基础的 GPT 实验项目,使用本地化的 GPT 大模型与数据和环境进行交互,无数据泄露风险,100% 私密,100% 安全。

关于微信版大语言模型来了:跨时空对话李白、教你高情商说话,在线可玩的介绍现已完结,谢谢您的耐心阅读,如果想了解更多关于(慕FX)LLM大语言模型算法特训,带你转型AI大语言模型算法工程师、01-大语言模型发展、Chatopera 云服务支持大语言模型对话(LLM),定制您的聊天机器人、DB-GPT —— 数据库大语言模型的相关知识,请在本站寻找。

本文标签: